Meta. llama 3 모델 공개

페이지 정보

본문

Meta 는 llama 3 모델 두종류 8b, 30b 를 공개했습니다.

> 이하 구글 번역

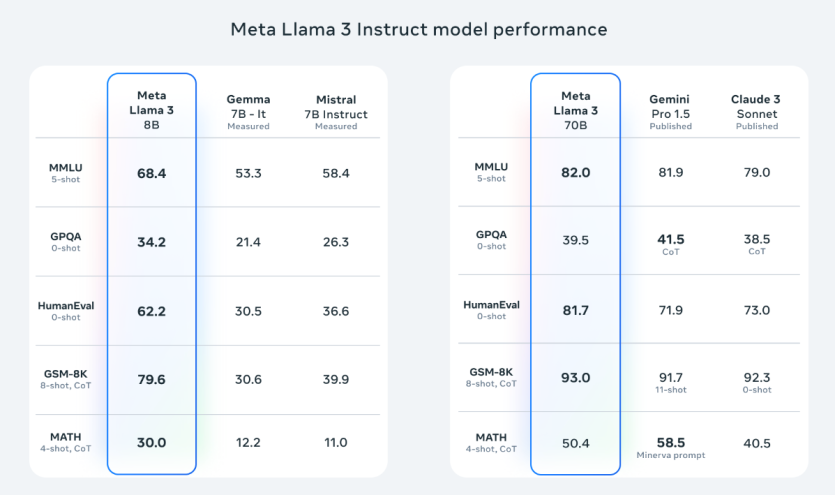

최첨단 성능

새로운 8B 및 70B 매개변수 Llama 3 모델은 Llama 2에 비해 큰 도약을 이루었으며 해당 규모에서 LLM 모델을 위한 새로운 최첨단 모델을 확립했습니다. 사전 훈련 및 사후 훈련의 개선 덕분에 사전 훈련 및 지침 미세 조정 모델은 현재 8B 및 70B 매개변수 규모에서 현존하는 최고의 모델입니다. 훈련 후 절차의 개선으로 거짓 거부율이 크게 감소하고 정렬이 개선되었으며 모델 응답의 다양성이 증가했습니다. 또한 Llama 3의 조종성을 더욱 향상시킨 후 추론, 코드 생성, 지침과 같은 기능이 크게 향상되었습니다.

Llama 3 개발 과정에서 우리는 표준 벤치마크에서 모델 성능을 살펴보고 실제 시나리오에 맞게 성능을 최적화하려고 노력했습니다. 이를 위해 우리는 새로운 고품질 인간 평가 세트를 개발했습니다. 이 평가 세트에는 조언 요청, 브레인스토밍, 분류, 폐쇄형 질문 답변, 코딩, 창의적 글쓰기, 추출, 캐릭터/페르소나 거주, 공개 질문 답변, 추론, 재작성 및 요약 등 12가지 주요 사용 사례를 다루는 1,800개의 프롬프트가 포함되어 있습니다. 이 평가 세트에서 우리 모델이 실수로 과적합되는 것을 방지하기 위해 우리 모델링 팀도 이에 액세스할 수 없습니다. 아래 차트는 이러한 범주에 대한 인간 평가의 집계 결과와 Claude Sonnet, Mistral Medium 및 GPT-3.5에 대한 프롬프트를 보여줍니다.

모델 아키텍처

우리의 디자인 철학에 따라 Llama 3에서는 비교적 표준적인 디코더 전용 변환기 아키텍처를 선택했습니다. Llama 2와 비교하여 몇 가지 주요 개선 사항을 적용했습니다. Llama 3는 언어를 훨씬 더 효율적으로 인코딩하는 128,000개의 토큰 어휘가 포함된 토크나이저를 사용하여 모델 성능을 크게 향상시킵니다. Llama 3 모델의 추론 효율성을 향상시키기 위해 8B 및 70B 크기 모두에 GQA(그룹화된 쿼리 주의)를 채택했습니다. 우리는 self-attention이 문서 경계를 넘지 않도록 마스크를 사용하여 8,192개의 토큰 시퀀스에 대해 모델을 훈련했습니다.

훈련 데이터

최고의 언어 모델을 훈련하려면 대규모의 고품질 훈련 데이터세트를 큐레이션하는 것이 무엇보다 중요합니다. 우리의 설계 원칙에 따라 우리는 데이터 사전 훈련에 막대한 투자를 했습니다. Llama 3는 공개적으로 사용 가능한 소스에서 수집된 15T개 이상의 토큰을 사용하여 사전 훈련되었습니다. 우리의 훈련 데이터 세트는 Llama 2에 사용된 것보다 7배 더 크고 4배 더 많은 코드를 포함합니다. 다가오는 다국어 사용 사례에 대비하기 위해 Llama 3 사전 학습 데이터 세트의 5% 이상이 30개 이상의 언어를 포괄하는 고품질 비영어 데이터로 구성됩니다. 그러나 이러한 언어에서는 영어와 동일한 수준의 성능을 기대하지 않습니다.

Llama 3가 최고 품질의 데이터에 대해 훈련되도록 보장하기 위해 우리는 일련의 데이터 필터링 파이프라인을 개발했습니다. 이러한 파이프라인에는 휴리스틱 필터, NSFW 필터, 의미론적 중복 제거 접근 방식 및 텍스트 분류자를 사용하여 데이터 품질을 예측하는 것이 포함됩니다. 우리는 이전 세대의 Llama가 고품질 데이터를 식별하는 데 놀라울 만큼 뛰어나다는 사실을 발견했습니다. 따라서 Llama 2를 사용하여 Llama 3를 구동하는 텍스트 품질 분류자를 위한 훈련 데이터를 생성했습니다.

또한 최종 사전 훈련 데이터 세트에서 다양한 소스의 데이터를 혼합하는 가장 좋은 방법을 평가하기 위해 광범위한 실험을 수행했습니다. 이러한 실험을 통해 우리는 퀴즈 질문, STEM, 코딩, 역사적 지식 등 을 포함한 사용 사례 전반에서 Llama 3가 잘 작동하도록 보장하는 데이터 혼합을 선택할 수 있었습니다.

사전 학습 확장

Llama 3 모델에서 사전 훈련 데이터를 효과적으로 활용하기 위해 사전 훈련을 확장하는 데 상당한 노력을 기울였습니다. 특히 우리는 다운스트림 벤치마크 평가를 위한 일련의 세부적인 확장 법칙을 개발했습니다. 이러한 확장 법칙을 통해 우리는 최적의 데이터 조합을 선택하고 교육 컴퓨팅을 가장 잘 사용하는 방법에 대해 정보에 입각한 결정을 내릴 수 있습니다. 중요한 것은 확장 법칙을 통해 모델을 실제로 훈련하기 전에 주요 작업(예: HumanEval 벤치마크에서 평가된 코드 생성, 위 참조)에 대한 가장 큰 모델의 성능을 예측할 수 있다는 것입니다. 이를 통해 다양한 사용 사례와 기능에 걸쳐 최종 모델의 강력한 성능을 보장할 수 있습니다.

우리는 Llama 3을 개발하는 동안 확장 동작에 대해 몇 가지 새로운 관찰을 했습니다. 예를 들어, 8B 매개변수 모델에 대한 Chinchilla 최적의 훈련 컴퓨팅 양은 ~200B 토큰에 해당하지만 모델 성능은 모델 이후에도 계속 향상된다는 것을 발견했습니다. 두 배 더 많은 데이터에 대해 훈련되었습니다. 8B 및 70B 매개변수 모델은 최대 15T 토큰에 대해 교육한 후 로그 선형적으로 계속 개선되었습니다. 더 큰 모델은 더 적은 훈련 컴퓨팅으로 이러한 작은 모델의 성능을 일치시킬 수 있지만, 추론 중에 훨씬 더 효율적이기 때문에 더 작은 모델이 일반적으로 선호됩니다.

가장 큰 Llama 3 모델을 교육하기 위해 데이터 병렬화, 모델 병렬화, 파이프라인 병렬화라는 세 가지 유형의 병렬화를 결합했습니다. 가장 효율적인 구현은 16K GPU에서 동시에 훈련할 때 GPU당 400TFLOPS 이상의 컴퓨팅 활용도를 달성합니다. 우리는 두 개의 맞춤형 24K GPU 클러스터 에서 훈련을 실행했습니다 . GPU 가동 시간을 극대화하기 위해 우리는 오류 감지, 처리 및 유지 관리를 자동화하는 새로운 고급 학습 스택을 개발했습니다. 또한 하드웨어 안정성과 자동 데이터 손상 감지 메커니즘을 크게 개선했으며, 체크포인트 및 롤백의 오버헤드를 줄이는 확장 가능한 새로운 스토리지 시스템을 개발했습니다. 이러한 개선으로 인해 전체적으로 효과적인 교육 시간이 95% 이상 증가했습니다. 이러한 개선 사항이 결합되어 Llama 2에 비해 Llama 3 훈련의 효율성이 최대 3배 증가했습니다.

명령어 미세 조정

채팅 사용 사례에서 사전 훈련된 모델의 잠재력을 완전히 활용하기 위해 지침 조정에 대한 접근 방식도 혁신했습니다. 사후 훈련에 대한 우리의 접근 방식은 감독된 미세 조정(SFT), 거부 샘플링, 근접 정책 최적화(PPO) 및 직접 정책 최적화(DPO)의 조합입니다. SFT에 사용되는 프롬프트의 품질과 PPO 및 DPO에 사용되는 선호도 순위는 정렬된 모델의 성능에 큰 영향을 미칩니다. 모델 품질의 가장 큰 개선 중 일부는 이 데이터를 신중하게 선별하고 사람 주석자가 제공한 주석에 대해 여러 차례의 품질 보증을 수행한 결과였습니다.

PPO 및 DPO를 통한 선호도 순위 학습을 통해 추론 및 코딩 작업에 대한 Llama 3의 성능도 크게 향상되었습니다. 우리는 모델에 대답하기 어려운 추론 질문을 하면 모델이 때때로 올바른 추론 추적을 생성한다는 사실을 발견했습니다. 모델은 올바른 답을 생성하는 방법을 알고 있지만 이를 선택하는 방법은 모릅니다. 선호도 순위에 대한 교육을 통해 모델은 이를 선택하는 방법을 학습할 수 있습니다.

iamchp님의 댓글