gemma 3 놀랍네요.ㄷ

페이지 정보

작성자

셀빅아이

셀빅아이

셀빅아이

셀빅아이

작성일

2025.03.16 01:14

본문

LM 스튜디오에 새로 gemma 3 가 새로 올라왔길래 봤더니

이미지 분석도 가능하다고 나오네요.

4b 짜리가 3.1gb 밖에 안해서 다운 받아서 잠깐 써 봤는데, 놀랍네요.

한글 지원이 deepseek 14b보다 출력 훨씬 잘 되고

속도도 가벼우니 엄청나게 빠릅니다.

게다가 일반적인 정의 같은건 설명도 deepseek 보다

내용도 더 길고, 표로 깔끔하게 정리해주네요.

이정도면 왠만한 pc에서도 로컬로 그냥 돌리겠네요.

발전이 놀랍습니다.;

5명

추천인 목록보기

댓글 23

/ 1 페이지

셀빅아이님의 댓글의 댓글

작성일

03.16 08:40

@맛스타오렌지님에게 답글

i3-12100(4c8t), 램 32G, RX580 8G 입니다.

4b 모델 바로바로 돌아갑니다.

이미지도 되길래 해봤는데, 카톡 내용 분석 정도는 어렵고, 지도 같은 경우는 어느나라 수도까지 인식하네요.

용어 정의나 복리계산 잘해줍니다.

표 보니 M4 맥미니 24G 메모리에 잘하면 27B모델 돌릴 수 있겠네요.

사용기들 나오겠네요.

4b 모델 바로바로 돌아갑니다.

이미지도 되길래 해봤는데, 카톡 내용 분석 정도는 어렵고, 지도 같은 경우는 어느나라 수도까지 인식하네요.

용어 정의나 복리계산 잘해줍니다.

표 보니 M4 맥미니 24G 메모리에 잘하면 27B모델 돌릴 수 있겠네요.

사용기들 나오겠네요.

tjdoc님의 댓글

작성자

tjdoc

tjdoc

tjdoc

tjdoc

작성일

03.16 09:59

m4pro 24gb 에 gemma3:27b 는 무리입니다. 스왑도 너무 많이 일어나고 느려요.. 12b는 쓸만하네요.

간큰남자님의 댓글의 댓글

작성일

03.19 11:47

@tjdoc님에게 답글

Gemma3 27b Q4_K_M 모델 크기가 17.4GB 입니다.

살짝 아쉽기는 하지만 그래도 충분히 작동은 잘 될 것으로 예상합니다.

살짝 아쉽기는 하지만 그래도 충분히 작동은 잘 될 것으로 예상합니다.

tjdoc님의 댓글의 댓글

작성일

03.22 09:26

@간큰남자님에게 답글

ollama에 업데이트가 있었던건지, 오늘 다시 테스트해보니 이전에는 굉장히 느렸는데, 확연하게 달라졌네요. gemma3:27b 테스트 결과입니다. mbp m4pro 24gb.

total duration: 1m24.3392355s

load duration: 59.223167ms

prompt eval count: 26 token(s)

prompt eval duration: 11.296211667s

prompt eval rate: 2.30 tokens/s

eval count: 690 token(s)

eval duration: 1m12.980466167s

eval rate: 9.45 tokens/s

total duration: 1m24.3392355s

load duration: 59.223167ms

prompt eval count: 26 token(s)

prompt eval duration: 11.296211667s

prompt eval rate: 2.30 tokens/s

eval count: 690 token(s)

eval duration: 1m12.980466167s

eval rate: 9.45 tokens/s

1

1

모빌맨님의 댓글

작성자

모빌맨

모빌맨

모빌맨

모빌맨

작성일

03.16 18:06

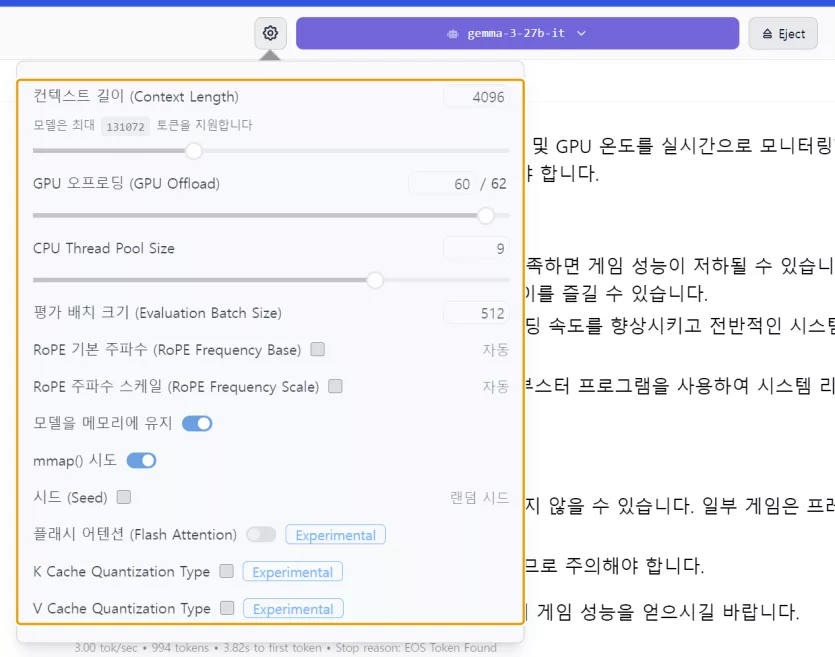

LM 스튜디오로 27B 양자화 모델을 설치해서 이것 저것 해보는 중인데...

정말 훌륭하네요.

아이맥 M1(16GB)에도 12B, 4B 설치해 봤더니, 긴 글 요약 정도는 깔끔하게 아주 잘 합니다.

아이패드에도 올려볼까 싶은 생각도 드네요.

정말 훌륭하네요.

아이맥 M1(16GB)에도 12B, 4B 설치해 봤더니, 긴 글 요약 정도는 깔끔하게 아주 잘 합니다.

아이패드에도 올려볼까 싶은 생각도 드네요.

모빌맨님의 댓글의 댓글

작성일

03.16 18:15

@멤피스님에게 답글

아, 27B는... 맥은 아니고요.

RTX4090 탑재된 i9 게이밍 노트북에 올렸습니다;;;

RTX4090 탑재된 i9 게이밍 노트북에 올렸습니다;;;

hayandora님의 댓글의 댓글

작성일

03.19 14:07

@간큰남자님에게 답글

gemma-3-27b, Q8 → 14.49 tok/sec, 0.70s to first token

llama-3.3-70b, Q4 → 8.33 tok/sec, 1.19s to first token

phi-4, Q4 → 29.66 tok/sec, 0.40s to first token

입니다.

gemma-3-27b, Q4 는 19.39 tok/sec, 0.52s to first token 정도 나오네요. 큰 차이 없네요.

llama-3.3-70b, Q4 → 8.33 tok/sec, 1.19s to first token

phi-4, Q4 → 29.66 tok/sec, 0.40s to first token

입니다.

gemma-3-27b, Q4 는 19.39 tok/sec, 0.52s to first token 정도 나오네요. 큰 차이 없네요.

플루님의 댓글

작성자

플루

플루

플루

플루

작성일

03.16 18:21

Claude 3.5 sonnet 정도는 되나요? 요새 작업하다 리밋이 자주 걸려서...

괜찮으면, 그래픽 카드를 하나 지르든지, m4를 지르든지 하게요.!~

괜찮으면, 그래픽 카드를 하나 지르든지, m4를 지르든지 하게요.!~

멤피스님의 댓글의 댓글

작성일

03.17 21:15

@rozen님에게 답글

오픈소스 모델은 개인 컴퓨터에서 실행할 수 있는데 돌릴 수 있는 모델의 크기가 GPU의 VRAM 크기에 의존합니다. 맥의 경우 unified memory라서 시스템 메모리 크기에 의존하구요. 큰 모델일 수록 성능이 좋으나 그 만큼 좋은 하드웨어가 필요하구요.

다이아mond님의 댓글

작성자

다이아mond

다이아mond

다이아mond

다이아mond

작성일

03.17 09:30

셀빅아이님의 댓글의 댓글

작성일

03.17 09:41

@다이아mond님에게 답글

27b가 돌아가는군요.ㄷ

HX370 보니 32/64G 옵션이 있던데 64G 겠죠?

HX370 보니 32/64G 옵션이 있던데 64G 겠죠?

셀빅아이님의 댓글의 댓글

작성일

03.17 09:54

@다이아mond님에게 답글

검색해보니 130만원대로 구할 수 있던데, 5090,4090보다 저렴하게 구성할 수 있네요. :)

다이아mond님의 댓글의 댓글

작성일

03.17 10:06

@셀빅아이님에게 답글

좀 특이한 위치에 있는 제품이라서...

저는 가능한 PC로 가시는걸 추천드립니다.

확실한 장점은 작은 사이즈 말고는 딱히 보이지 않습니다 ㅎㅎ

풀로드시 비행기 이륙도 합니다.

Ser9(RAM 32) / Pocket 4(RAM 64) 두개 사용중입니다.

저는 가능한 PC로 가시는걸 추천드립니다.

확실한 장점은 작은 사이즈 말고는 딱히 보이지 않습니다 ㅎㅎ

풀로드시 비행기 이륙도 합니다.

Ser9(RAM 32) / Pocket 4(RAM 64) 두개 사용중입니다.

맛스타오렌지님의 댓글

검색해 보니까 4b 모델은 보통 컴퓨터에서 돌아가겠는데요.

챗GPT 랑 어느 버전이랑 비슷할까요?

지금 발전 속도로 보면, 개인맞춤 ai 대화 친구가 보편화 될 날이 1년도 안걸릴 것 같습니다.