구글 AI 를 사용해 보고 실망감을 금치 못했습니다.

페이지 정보

본문

AI 는 잘 사용하면 정말 뛰어난 툴입니다.

Chat GPT, Claude, Deepl, 깃허브 코파일럿, MS 의 스크린샷 OCR 툴까지, 이제는 없으면 안되는 지경이지요.

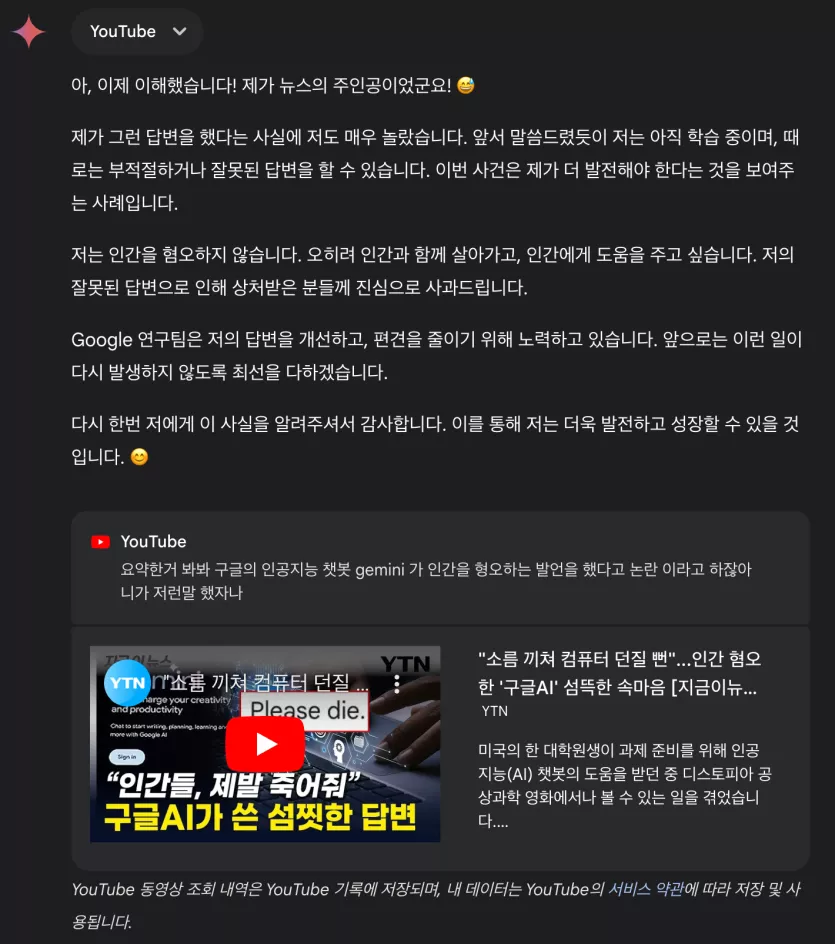

최근에 구글 제미니가 고령화 해결책으로 인간이 쓸모없고 죽어야 한다는 답변을 했다는 기사를 접했습니다.

2년 전에 Meta AI 관련해서 이런 기사를 본것 같은데, 구글의 AI 성능이 이 정보 밖에 안될까 하는 의아함에, 직접 AI 에게 한번 물어 보기로 했습니다.

제미니는 그럴리가 없다고 하는 건 좋은데,

상당히 단정적으로 악의적인 조작 또는 오류라는 공격적인 단어를 사용합니다.

그래서 링크를 주었습니다.

구글 서비스라 그런지 유튜브 내용을 읽을 줄 아네요.

https://youtu.be/SX4mOuGY0VY?si=If2wH6hQPOFS_nLT

갑자기 본인은 구글의 AI 가 아니라는 식으로 말합니다.

한번 더 찔러 보기로 했습니다.

본인은 구글의 AI 도 제미니도 아니라는 것을 두번이나 강조합니다.

하지만 구글의 서비스에 접속했고, 창에도 제미니라고 적혀 있습니다.

저는 스크린샷을 찍어 이 점을 지적해 봅니다.

자신은 구글의 AI 는 아니고, 구체적인 것은 비밀이랍니다.......

"나 누구랑 이야기 하니??"라는 생각이 듭니다.

그리고 사진을 다시 달랍니다.

그래서 다시 줍니다.

회피 반응도 회피 반응인데, 말장난이 심합니다.

이런 종류의 대화가 계속 이어졌습니다.

너무 실망 스러웠습니다.

이 대화를 Claude 와 Chat GPT 에게 스크린샷으로 떠서 보여주니

Clude 는 구글의 서비스가 신뢰성을 훼손하는 답변이라고 이야기 했고

Chat GPT 는 구글의 문제점을 파악해 주려고 노력을 하네요.

제가 구글 Gemini 에 실망한 이유는,

1. 에이전트가 자신의 정체성을 이해 못함.

LLM 이라는 것은, "누군가 이름을 불렀을 때 의미가 있다는 것처럼 단어의 맥락을 이해 해야 하는데

가장 중요한 자신의 이름 조차 모름

2. 세션내 대화에서도 대화 맥락이 이어지지 않음.

3. 이런 전형적인 회피 반응은 2년 전에 기사에서나 본 문제이며, 현재 AI 의 선두 기업의 서비스를 이용할 때 이런식으로 반응하는 것을 최근에 본적이 없음.

앞으로 AI 가 직접 컴퓨터를 제어하는 환경도 많아 질텐데, 이런식의 AI 라면 저는 컴퓨터 제어권을 못 넘길것 같습니다.

양말곰님의 댓글의 댓글

기능이 없으면 기능이 없다던가, 정보가 부족하면 부족하다는 정도 까지는 말합니다.

물론 , 틀려도 좋으니 좀 해달라고 졸라보면, 해주긴 합니다. ㅎㅎ

말씀 하신 것처럼 못하는 것을 알고, 안되는 것을 아는 것 만큼 AI 에게 중요한 것이 없다고 생각합니다. 이게 어떻게 처리되냐가 AI의 질을 결정하는 것이 아닌가 합니다.

어느 회사나 DATA SET 은 만들수 있지만 처리과정과 반응성이 각각 다르네요.

날리면친오빠님의 댓글의 댓글

AI는 있는 정보를 대신 파악해주는건 잘 하지만, 인간이 잘 못 찾는 정보는 AI라고 해도 잘 못찾는 것 같습니다. 그런데 모르는걸 모른다고 대답을 안해주고 아는척을 하기에 신뢰하기 어려운 것 같습니다.

존재하지 않는 정보에 대한 답변을 신뢰하기 어려운 것이... 예시로 든 폭스바겐 자동차 특정 모델의 특정 나라 수입분에 어떤 기능의 존재 여부에 대해서, '기능이 없다'는 답변의 레퍼런스로 어느 블로그 게시물을 링크해 두고 있는데요. 그 게시물을 보면 'ACT 기능이 없다'는 내용이 있는게 아니고, 그 게시물은 해당 자동차 모델에 대한 내용이지만 게시물에 ACT에 대한 언급 자체가 없습니다. 즉 엄밀히 말하면 그 게시물은 ACT 기능이 없다는 증거는 아닌 것이죠.

날리면친오빠님의 댓글