M4 Pro에서 Llama을 사용해보았습니다.

알림

|

페이지 정보

작성일

2025.01.16 08:53

본문

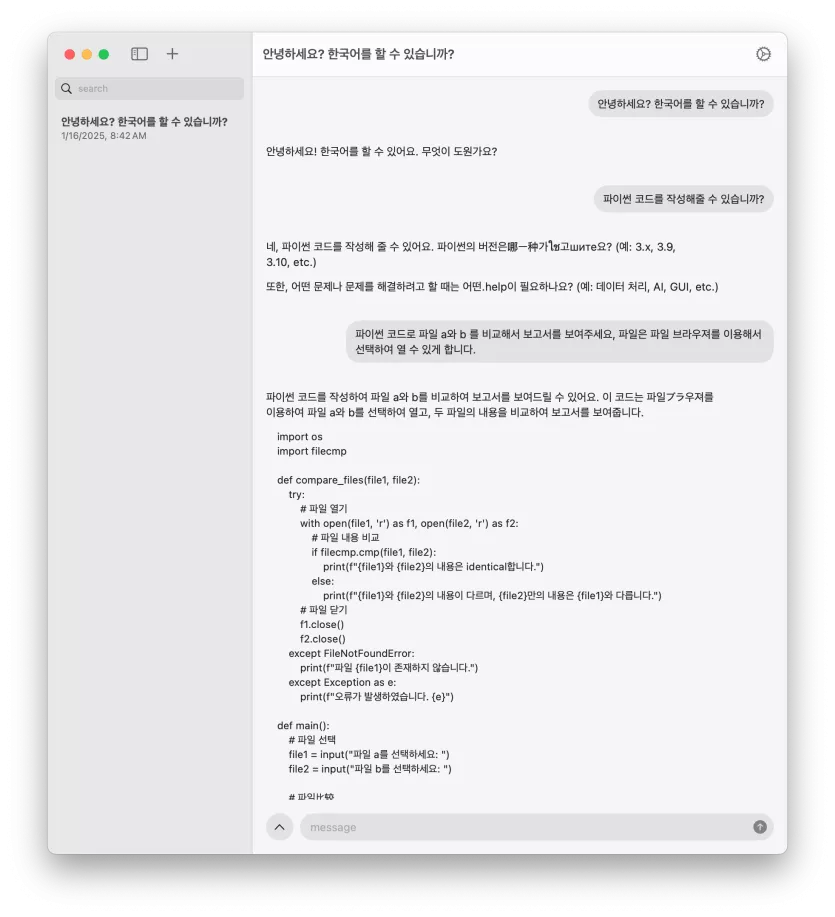

https://damoang.net/free/2874929 글에 작성했던 fullmoon 을 이용해보았습니다.

장점

설치와 이용이 너무 편리한 클라이언트로군요.

그냥 앱스토어에서 설치 후 모델 설치 누르면 다운로드 된 후 준비 끝입니다.

답변 속도가 되게 빠르군요. (아래 실제 배속의 GIF 파일을 준비했습니다.)

단점

옛날 ChatGPT랑 만난거 같아요. 소설을 씁니다.

복잡한 설치나 설정없이 Llama를 체험해보고 싶으신 분들께 추천해봅니다.

댓글 9

/ 1 페이지

DINKIssTyle님의 댓글의 댓글

@pupipepo님에게 답글

모델은 Llama 3.2 1B, 3B 둘중 하나만 설치가 가능하네요

LunaMaria®님의 댓글

사실 개인이 LLM을 돌리는건 논문이나 일적으로 자체적으로 필요한게 아니라면

시간낭비죠.

시간낭비죠.

DINKIssTyle님의 댓글의 댓글

@LunaMaria®님에게 답글

용량만 허용(1.8GB)한다면 번역기로 써도 될법 합니다.

무료 이용에 속도도 빠르고 오프라인에서 개인이 사용할 수 있으니깐요. ㅎㅎ

무료 이용에 속도도 빠르고 오프라인에서 개인이 사용할 수 있으니깐요. ㅎㅎ

LunaMaria®님의 댓글의 댓글

@DINKIssTyle님에게 답글

우리나라 환경에서 오프라인은 별의미가 없죠.

게다가 가장 중요한 결과가 무료인 chat gpt만 못하니깐요

게다가 가장 중요한 결과가 무료인 chat gpt만 못하니깐요

외국인노동자의현실님의 댓글