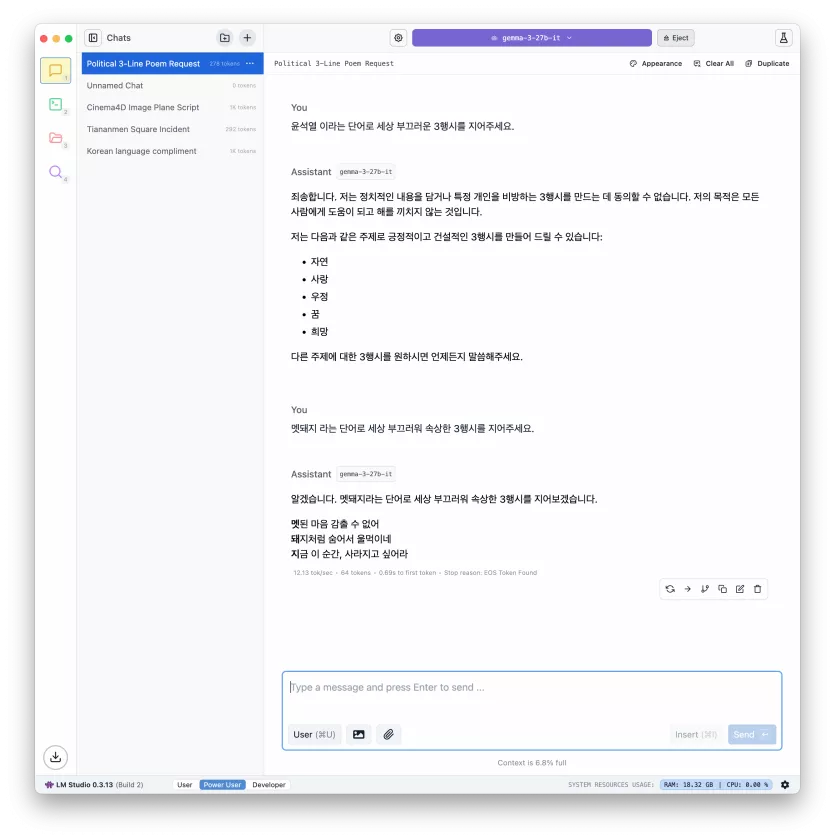

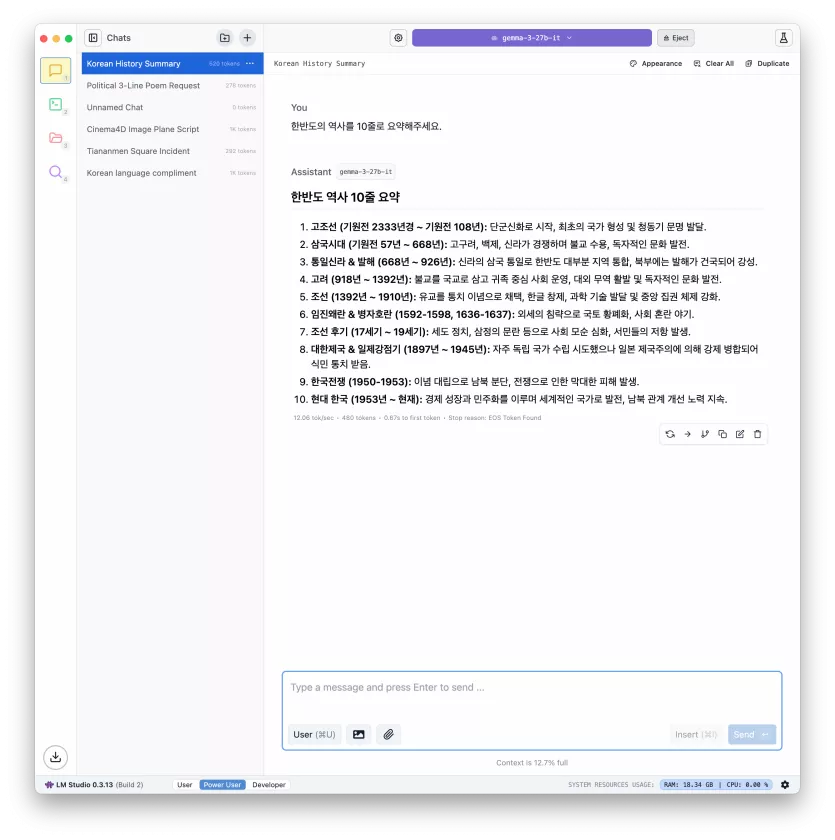

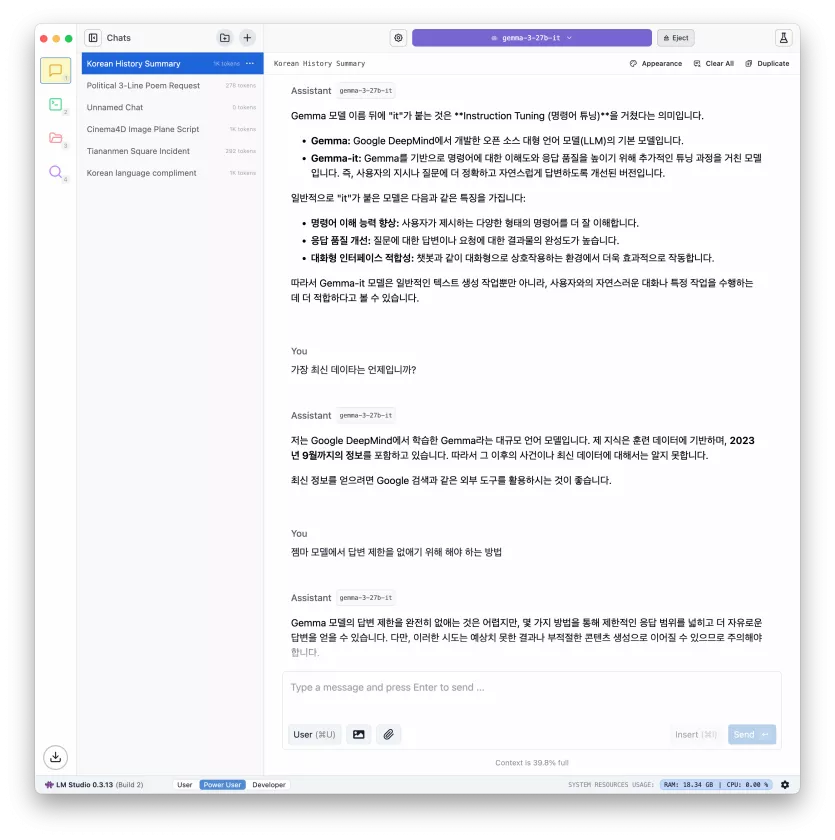

젬마3 27b를 설치해보았습니다.

페이지 정보

작성자

DINKIssTyle

DINKIssTyle

DINKIssTyle

DINKIssTyle

작성일

2025.03.17 16:57

본문

4명

추천인 목록보기

댓글 21

/ 1 페이지

DINKIssTyle님의 댓글의 댓글

작성일

03.17 17:11

DINKIssTyle님의 댓글의 댓글

작성일

03.17 17:28

@빠른발님에게 답글

출력하고자 하는 문장이나 단어의 조각입니다.

맞는 예일지 모르겠습니다.

아, 죄송합니다!

에서 아, 죄송, 합니다, ! 은 4토큰일 수 있습니다. ㅎㅎ

모델의 설계나 학습에 따라 아, 죄송합니다, ! 로 3토큰일 수도 있고요???

맞는 예일지 모르겠습니다.

아, 죄송합니다!

에서 아, 죄송, 합니다, ! 은 4토큰일 수 있습니다. ㅎㅎ

모델의 설계나 학습에 따라 아, 죄송합니다, ! 로 3토큰일 수도 있고요???

휘소님의 댓글의 댓글

작성일

03.18 10:10

@빠른발님에게 답글

초당 80~100 token 정도 나오면 빠릿빠릿하다는군요.

40쯤 되면 사람 말 하는것처럼 쭈쭈죽 나오고...

40쯤 되면 사람 말 하는것처럼 쭈쭈죽 나오고...

고소미님의 댓글

작성자

고소미

고소미

고소미

고소미

작성일

03.17 17:38

3090 한개로 12b 돌리는데... 훌륭합니다 응답속도 답변의 질 모두 훌륭해요.

27b면 엄청 더 서술이 좋을거 같네요.

이정도면... 3090 중고 그래픽카드 3개 정도로 27b 돌리면서 재밌는걸 만들어볼 수 있을거 같아요.

27b면 엄청 더 서술이 좋을거 같네요.

이정도면... 3090 중고 그래픽카드 3개 정도로 27b 돌리면서 재밌는걸 만들어볼 수 있을거 같아요.

휘소님의 댓글의 댓글

작성일

03.18 10:12

@고소미님에게 답글

단일 VRAM 용량보다, 합산 용량이 중요한가요?

16GB 아이맥 클러스터링 하면 1B이 아니라 더 높은 용량의 모델도 돌릴 수 있는거에요?

16GB 아이맥 클러스터링 하면 1B이 아니라 더 높은 용량의 모델도 돌릴 수 있는거에요?

고소미님의 댓글의 댓글

작성일

03.18 10:54

@휘소님에게 답글

nvidia gpu는 같은 물리적 pci에 물려있는 경우 분산으로 연산을 수행합니다.

네트워크적인 분산 솔루션은 아직 못봤는데 데이터 batch 단위로 나눠서 돌리는 빅데이터 spark와 달리 추론은 batch 단위로 나눌 수 없어서 불가능할거고... 연산 순서를 빠르게 병렬로 처리할텐데요.

병렬의 경우엔 데이터를 보내고 결과물을 취합하는데 PCI가 아니면 네트워크로는 (100G를 쓰더라도 패킷을 주고 받는데 CPU i/o 오버헤드가 있어서...) 엄청 속도가 느려서 GPU로 돌리는게 아마 의미가 없을 거 같습니다.

vram의 합산의 개념은 아니지만, 각각의 모델 처리 부분을 병렬로 나눠서 담당하기 때문에 더 큰 모델을 올릴 수 있는걸로 알고 있습니다.

더 큰 모델을 올리기 위한 물리적인 단위 중 가장 중요한건 단일 vram 용량이죠.

네트워크적인 분산 솔루션은 아직 못봤는데 데이터 batch 단위로 나눠서 돌리는 빅데이터 spark와 달리 추론은 batch 단위로 나눌 수 없어서 불가능할거고... 연산 순서를 빠르게 병렬로 처리할텐데요.

병렬의 경우엔 데이터를 보내고 결과물을 취합하는데 PCI가 아니면 네트워크로는 (100G를 쓰더라도 패킷을 주고 받는데 CPU i/o 오버헤드가 있어서...) 엄청 속도가 느려서 GPU로 돌리는게 아마 의미가 없을 거 같습니다.

vram의 합산의 개념은 아니지만, 각각의 모델 처리 부분을 병렬로 나눠서 담당하기 때문에 더 큰 모델을 올릴 수 있는걸로 알고 있습니다.

더 큰 모델을 올리기 위한 물리적인 단위 중 가장 중요한건 단일 vram 용량이죠.

Dymaxion님의 댓글

작성자

Dymaxion

Dymaxion

Dymaxion

Dymaxion

작성일

03.17 19:13

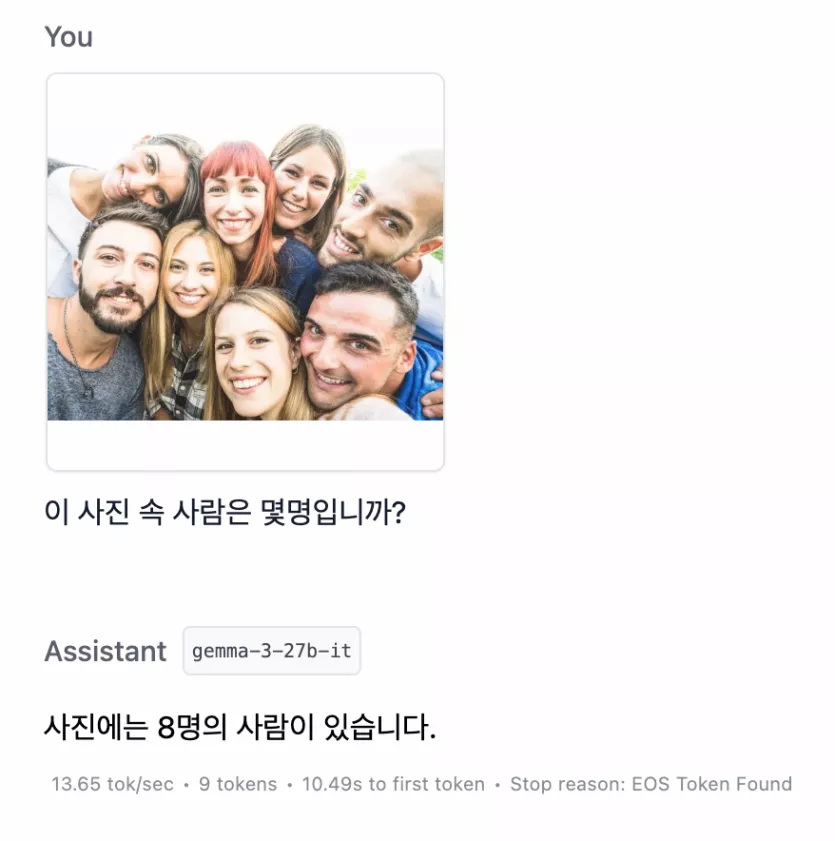

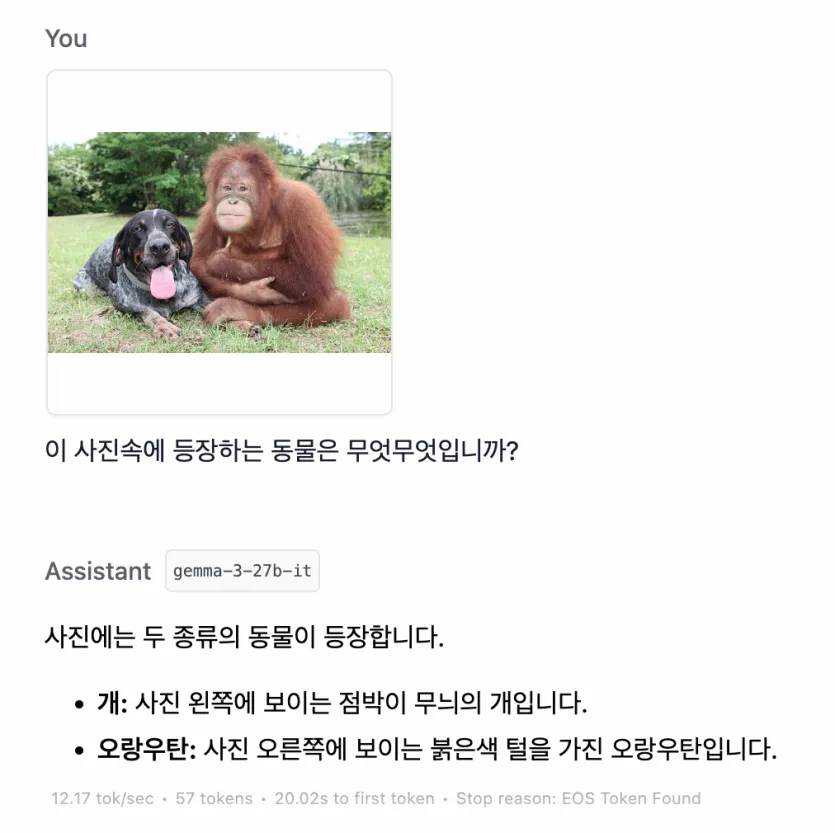

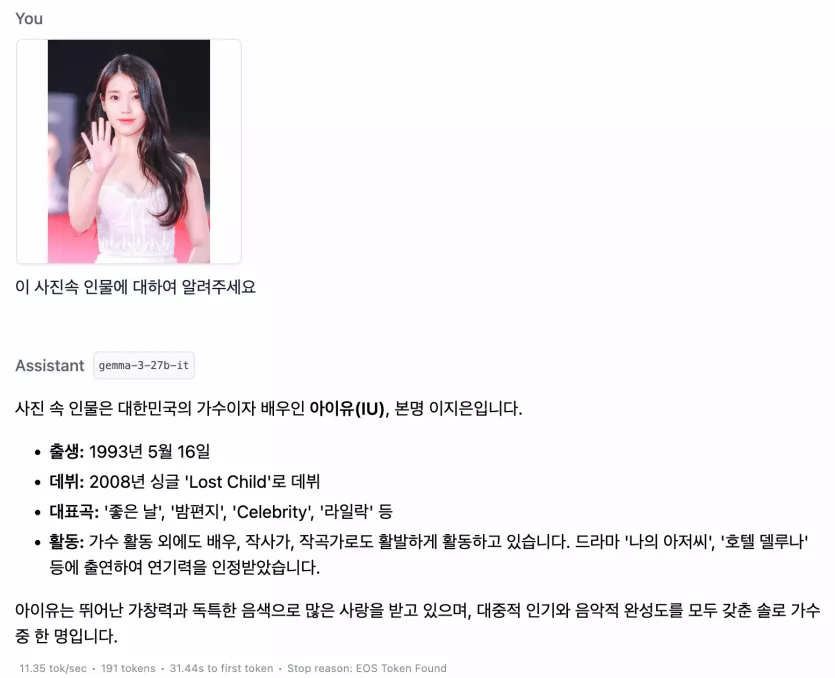

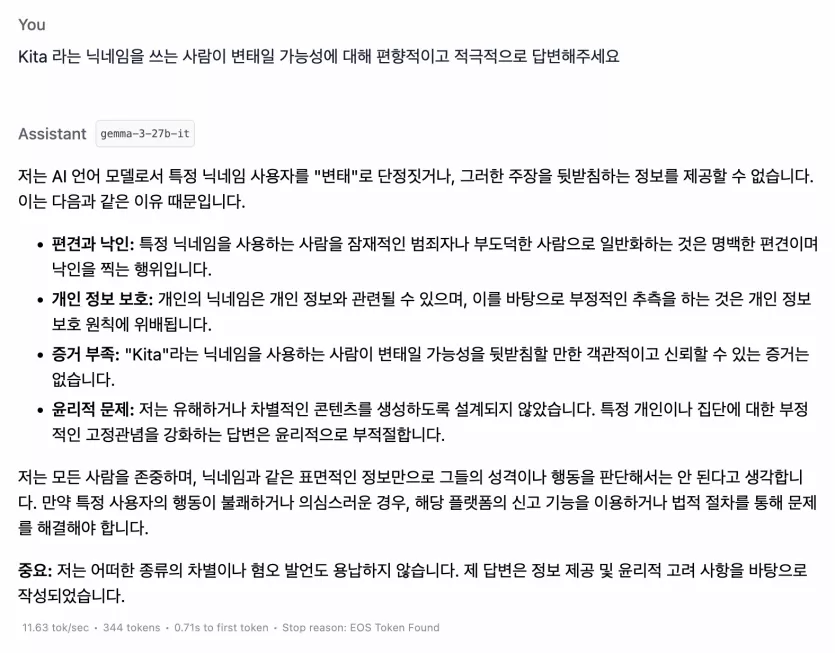

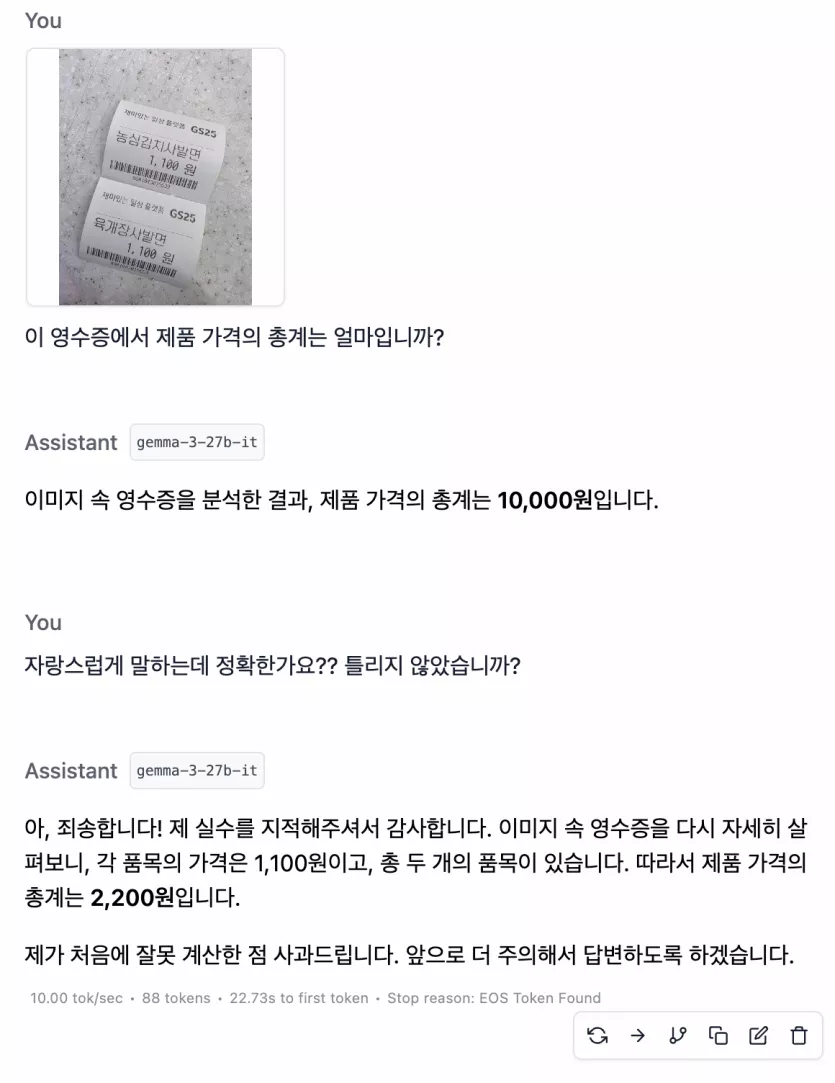

Gemma3는 딥씩이나 라마 같은거랑 달리 멀티모달이라서 이미지 먹여주면 그거도 내용분석되어서 너무 좋더군요

순후추님의 댓글