맥북프로 m4 24기가는 ai 입문용 수준이군요.

페이지 정보

작성자

코미

코미

코미

코미

작성일

2025.03.17 15:27

본문

전에 맥북 에어 m1 8기가가 ai 한참 부족해서 큰 맘 먹고 300만원 주고 맥북프로 m4 24기가 구매한 바 있습니다.

제 목표는 책이나 자료를 로컬 llm 모델에 학습시킨 후 그걸로 요약글, 퀴즈, 학습지, 프레젠테이션 초안 등을 만드는 겁니다.

그 외에도 여유가 되면 웹을 연동시켜 기존 자료에 최신 자료나 사진을 덧붙이는 것이나, 아예 그렇게 입력한 걸 자동으로 홈페이지에 게시해서 광고비 받아먹는 것도 생각하고 있어요.

ChatGPT를 유료 구독하며 드는 비용을 확 줄일 수 있으니까요.

근데... 역시 제가 너무 꿈이 높은 건지 24기가 램으로도 맛보기가 고작이군요.

어느 회사에 기대서 하기보다 내가 직접 작지만 직접 굴려보고 싶은데 역시 다음엔 128기가 램을 달아야...

1명

추천인 목록보기

댓글 20

/ 1 페이지

MDBK님의 댓글의 댓글

작성일

03.17 15:35

@규링님에게 답글

윈도에서 wsl로 구성한다음에 도메인 연결후 외부접속 만들어놨는데 잘 안쓰게 되더라고요. 그냥 맥에서 하는게 편하긴합니다.

규링님의 댓글의 댓글

작성일

03.17 15:44

@MDBK님에게 답글

전 아예 우분투 깔고 이용하는 본체를 따로 구성했는데...

정작 진짜 가벼운 에이전트 만드는 용도에서는 잘 안쓰게 되더군요.

여러모로 좀 더 심도있게 쓸 때나 학습시킬 때 정도에 주로 돌려보네요. ㅎㅎ

정작 진짜 가벼운 에이전트 만드는 용도에서는 잘 안쓰게 되더군요.

여러모로 좀 더 심도있게 쓸 때나 학습시킬 때 정도에 주로 돌려보네요. ㅎㅎ

김링크님의 댓글

작성자

김링크

김링크

김링크

김링크

작성일

03.17 15:32

추론은 램용량만 많으면 개인이 쓰기에 충분한 성능이 나오지만

학습은 다른 이야기 입니다.

뭐 학습은 별도의 기기에서 따로 굴린 후 중고로 팔아버려도 되긴 하지만요.

학습은 다른 이야기 입니다.

뭐 학습은 별도의 기기에서 따로 굴린 후 중고로 팔아버려도 되긴 하지만요.

김링크님의 댓글의 댓글

작성일

03.18 07:33

@코미님에게 답글

수명이 문제가 되는건 아니구요

추론은 그나마 돌려볼만한 정도의 성능이 나온다면

학습은 그냥 신품이든 중고든 최저가로 구할 수 있는 아무 글카나 갖다 써도 그거보다는 빠르겠다 싶은 속도입니다

추론은 그나마 돌려볼만한 정도의 성능이 나온다면

학습은 그냥 신품이든 중고든 최저가로 구할 수 있는 아무 글카나 갖다 써도 그거보다는 빠르겠다 싶은 속도입니다

DINKIssTyle님의 댓글

작성자

DINKIssTyle

DINKIssTyle

DINKIssTyle

DINKIssTyle

작성일

03.17 15:37

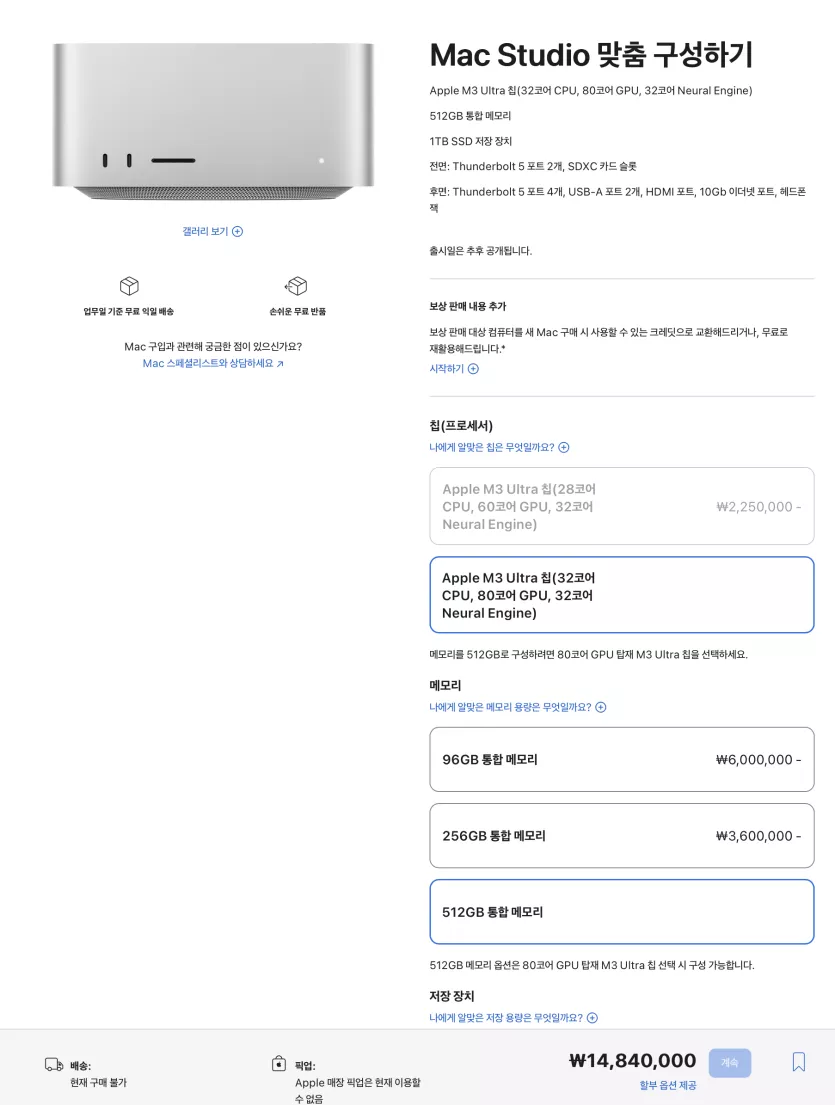

DINKIssTyle님의 댓글의 댓글

작성일

03.17 16:09

@LEC16님에게 답글

회사들은 땡길만한 가격이군요~

싸게 보이는 마법 ㄷㄷㄷ

싸게 보이는 마법 ㄷㄷㄷ

리코리안님의 댓글

작성자

리코리안

리코리안

리코리안

리코리안

작성일

03.17 15:40

llm 학습은 그냥 구독하시는걸 추천합니다. ; 구글 코랩 프로 월에 50달러면 더 좋은 성능, 전기비도 아껴가며 돌릴 수 있는데 그걸 굳이 로컬에서 할 이유가 없습니다. 저 같은 경우는 그냥 비전 모델 모바일에서 돌릴용으로 학습하는데 m1 pro 16gb 에서 한 일주일 학습 해서 씁니다. 근데 성능 좋은거 하려면 외부 시스템 빌리는게 젤 좋습니다.

DINKIssTyle님의 댓글의 댓글

작성일

03.17 17:33

@따끈따끈님에게 답글

맥에는 귀찮은 분들을 위해 옵션이 많은 듯 합니다. ㅋㅋ

LM Studio 설치하신 다음에 원하는 모델 설치하면 완료입니다~

LM Studio 설치하신 다음에 원하는 모델 설치하면 완료입니다~

규링님의 댓글

집에 4060 ti 16기가 두장 달아둔 녀석으로도 가능하지만

외부에서 접속이 안쉽네요. ㅠㅠ

가끔 생각나서 돌리는 장난감으로 하나 생각중입니다.