Mac에 로컬LLM(ChatGPT 같은걸..)을 설치하는 초간단 방법

페이지 정보

작성자

DINKIssTyle

DINKIssTyle

DINKIssTyle

DINKIssTyle

작성일

2025.03.17 20:53

본문

* 이 글은 자유게시판에서 복사해온 글입니다.

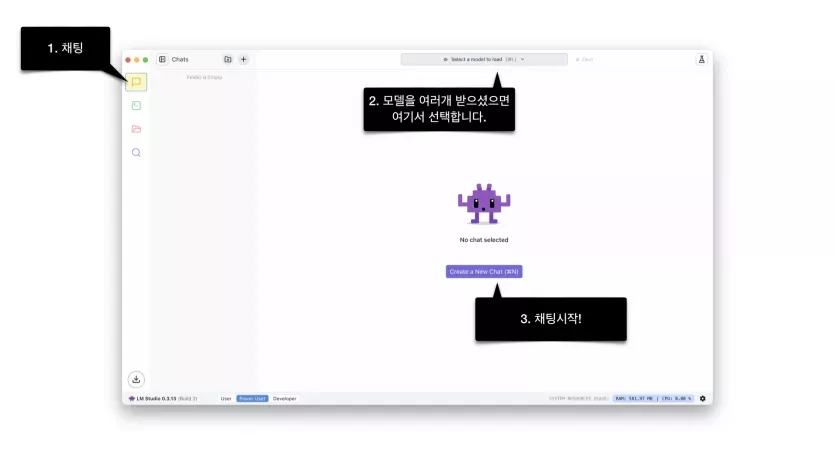

누구나 경험해볼 실 수 있도록 초초초초초보를 위한 가이드입니다.

https://lmstudio.ai/ 에 들어가셔서

다운로드 받아 응용프로그램 폴더에 넣어주세요.

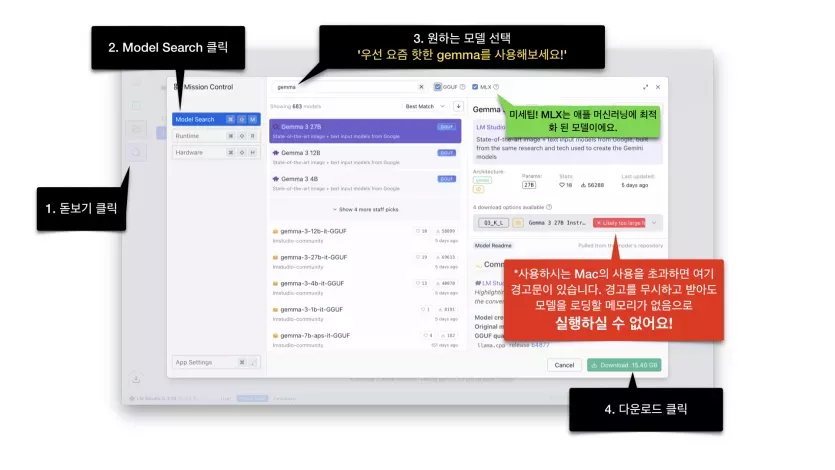

응용프로그램을 처음 실행하면 기본 LLM 모델을 설치하려고 하는데 설치하셔도 되고 안하셔도 됩니다.

만약 기본 LLM 모델 설치를 건너 뛰신 경우에는 맨 마지막 설명을 참고하세요.

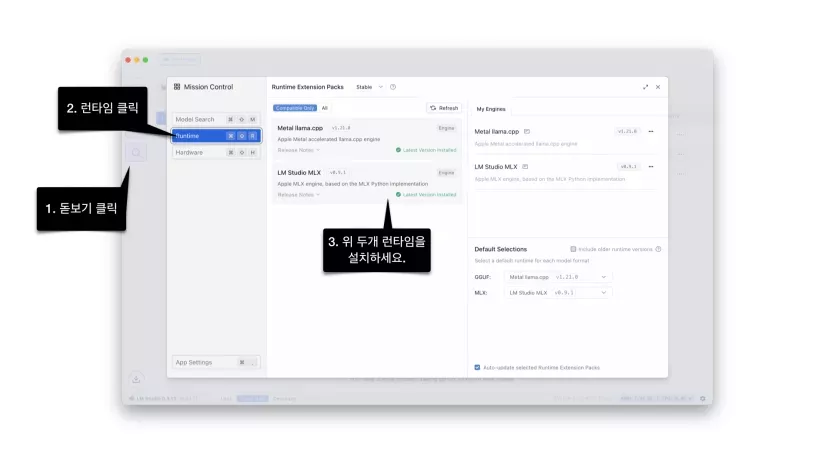

*기본 LLM 설치를 건너뛰신 경우 최소한의 런타임도 설치되어 있지 않습니다.

따라서 모델 검색도 안됩니다. 이렇게 런타임을 설치해주세요~

제가 사용하면서 느낀 점은..

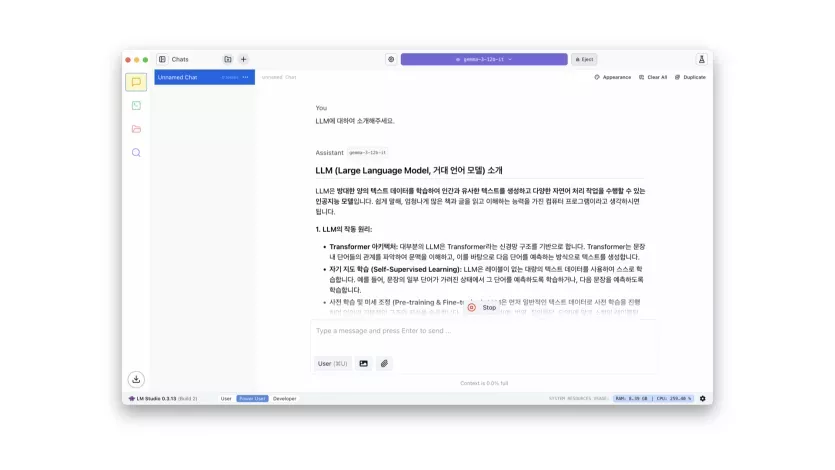

M4 Pro 64GB에서 12b는 날라다닙니다. ChatGPT 쾌적할 때보다 더 쾌적한거 같아요.

27b도 ChatGPT 만큼 토큰 속도가 나오기는 하는데..

답변이 길어질 수록 CPU+GPU 발열이 풀로드 상태가 됩니다.

M1 16GB에서는 12b도 사실 다른 고사양 작업들과 함께하면 화딱지가 나실 수도 있습니다.

16명

추천인 목록보기

댓글 6

/ 1 페이지

DINKIssTyle님의 댓글의 댓글

작성일

03.21 13:08

@슬립워커님에게 답글

오프라인 또는 내부망에서도 사용가능 민감한 자료를 내부에서 처리, 온라인 의존도 없음, 신뢰성 유지 등등 입니다. chatgpt의 경우 서버 몰리면 응답 온도가 내려가나 보더라구요.

DINKIssTyle님의 댓글

작성자

DINKIssTyle

DINKIssTyle

DINKIssTyle

DINKIssTyle

작성일

03.22 14:55

https://huggingface.co/collections/mlx-community/gemma-3-67d14a10480a436ad478b0f9

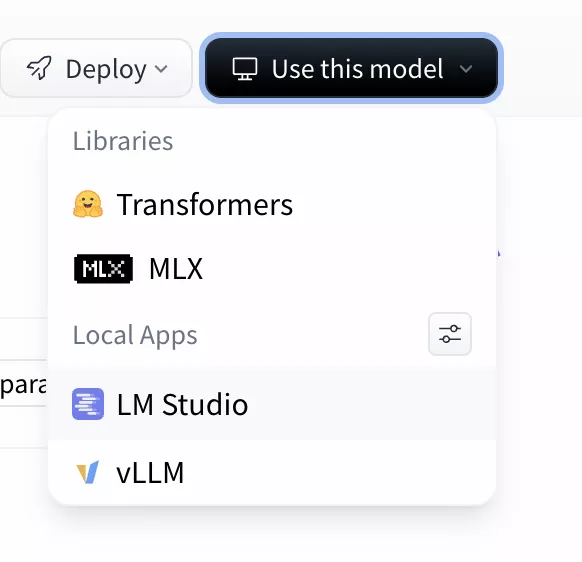

MLX로 된 Gemma 3 모델들이 올라왔습니다. 모델에 들어가신 다음에 Use this model 누르시고 LM Studio 를 선택하시면 됩니다.

MLX로 된 Gemma 3 모델들이 올라왔습니다. 모델에 들어가신 다음에 Use this model 누르시고 LM Studio 를 선택하시면 됩니다.

Ecridor님의 댓글