OpenAI, 어드밴스드 보이스 모드 순차 배포

페이지 정보

본문

* TechCrunch 기사

OpenAI rolls out Advanced Voice Mode with more voices and a new look

# 내용 일부 GPT-4o 번역

OpenAI가 화요일(현지 기준)부터 ChatGPT 유료 사용자에게 어드밴스드 보이스 모드(AVM)를 확대 제공한다고 발표했습니다. 이번 음성 기능은 ChatGPT와 대화를 더 자연스럽게 만들며, 우선 ChatGPT Plus와 Teams 요금제 구독자에게 제공됩니다. Enterprise와 Edu 사용자들은 다음 주부터 사용할 수 있습니다.

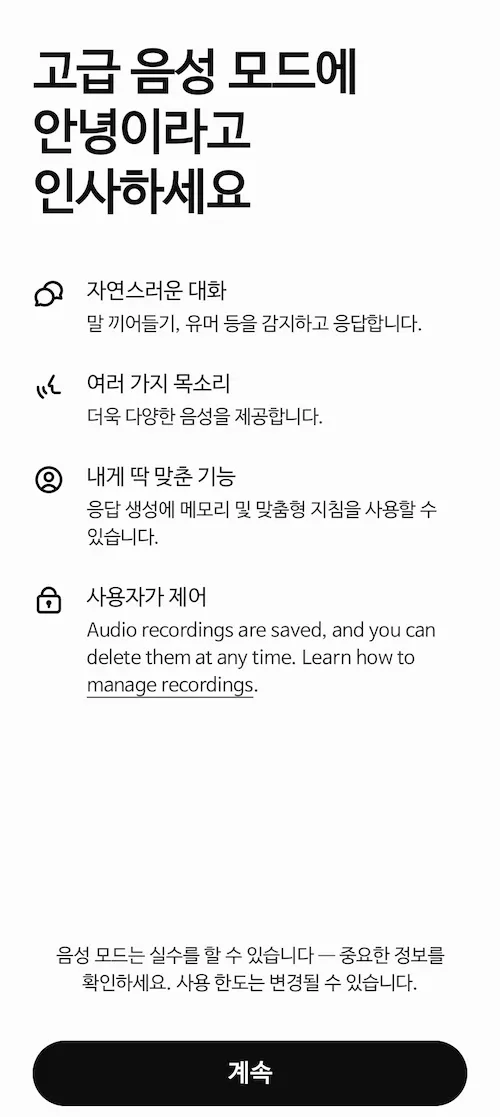

이번 출시와 함께 AVM이 새 디자인을 갖췄습니다. OpenAI가 5월에 처음 기술을 선보였을 때 사용했던 검은색 애니메이션 점 대신 파란색 애니메이션 원 모양으로 표현됩니다.

AVM이 활성화되면 사용자들은 ChatGPT 앱에서 음성 아이콘 옆에 팝업 알림을 받게 됩니다.

ChatGPT에서 선택할 수 있는 5가지 새 음성이 추가됐습니다 - Arbor, Maple, Sol, Spruce, Vale.

이로써 ChatGPT는 Breeze, Juniper, Cove, Ember와 함께 총 9가지 음성을 제공하게 되며, 구글의 Gemini Live와 비슷한 숫자입니다. 모든 이름이 자연에서 영감을 받은 것을 알 수 있는데, AVM 목표가 ChatGPT 사용을 더 자연스럽게 만드는 것과 관련이 있을 수 있습니다.

이번 라인업에서 빠진 음성은 Sky로, OpenAI 봄 업데이트에서 소개된 직후 스칼렛 요한슨으로부터 법적 위협을 받았던 음성입니다.

이번 출시에서 제외된 또 다른 기능은 4달 전 봄 업데이트에서 처음 선보였던 ChatGPT의 비디오 및 화면 공유 기능입니다. 이 기능은 GPT-4가 시각과 청각적 정보를 동시에 처리할 수 있도록 설계되었습니다. 시연에서 OpenAI 직원이 종이에 적힌 수학 문제나 컴퓨터 화면의 코드를 실시간으로 ChatGPT에게 질문할 수 있는 방법을 보여줬습니다. 현재 OpenAI는 이러한 멀티모달 기능 출시 일정은 밝히지 않았습니다. [이후 내용 생략]

# 아래 OpenAI X(트위터) 계정에서 올린 글

https://x.com/OpenAI/status/1838642444365369814

뱀상어님의 댓글의 댓글

/Vollago

가사라님의 댓글의 댓글

카메라나 이미지파일 인지가 안되기 때문에 순전히 텍스트로만 대화하던 것의 오디오 버전이라고 보셔야 합니다.

진짜는 카메라와 연동되는 때이죠.

Woogler님의 댓글