구글, 딥시크·GPT 보다 뛰어난 AI 모델 ‘젬마 3’ 공개

페이지 정보

작성자

셀빅아이

셀빅아이

셀빅아이

셀빅아이

작성일

2025.03.16 08:44

본문

* 25년 3월 13일 기사입니다.

구글이 3월 12일(현지시간) ‘젬마 3(Gemma 3)’를 공식 발표했다. 젬마 3는 단일 GPU 또는 TPU에서도 실행 가능한 고성능 AI 모델로, 경량화와 높은 성능을 동시에 갖춘 것이 특징이다. 이를 통해 개발자들은 보다 효율적으로 AI 애플리케이션을 구축할 수 있다.

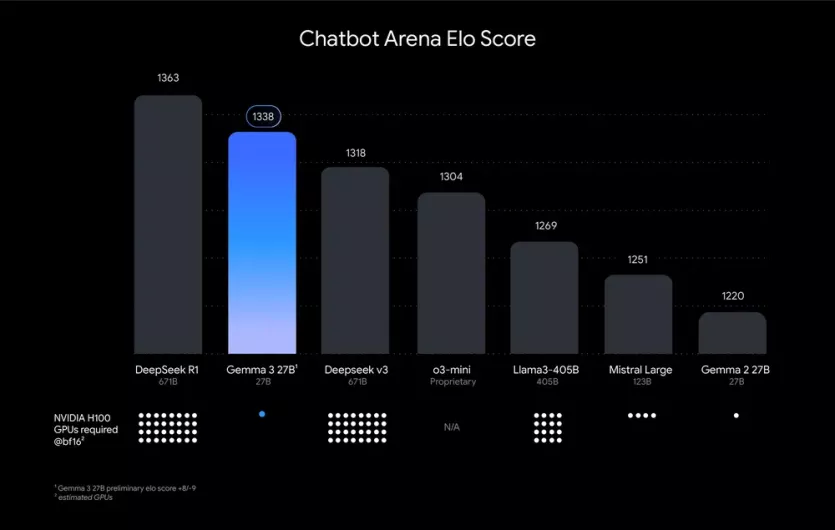

젬마 3는 1B, 4B, 12B, 27B 등 다양한 크기로 제공되며, 사용자의 하드웨어 및 성능 요구 사항에 따라 선택할 수 있다. 특히 27B 모델은 단일 GPU에서 실행 가능하면서도 Llama-405B, DeepSeek-V3, o3-mini 등 경쟁 모델을 뛰어넘는 성능을 보였다.

*blog.google/ Chatbot Arena Elo AI 모델을 순위. 점수가높을수록 사용자 선호도가 더 높다

또한 자연어 처리, 이미지 및 텍스트 분석, 짧은 비디오 처리 등 다양한 기능을 지원하며, 128K 토큰의 확장된 컨텍스트 윈도우를 제공해 더 복잡한 작업도 수행할 수 있다. 젬마 3는 140개 이상의 언어를 지원해 개발자들은 글로벌 시장을 대상으로 AI 애플리케이션을 구축할 수 있다. 또한 Hugging Face Transformers, PyTorch, JAX, Keras 등 다양한 개발 환경과 호환되며, NVIDIA, AMD GPU 및 Google Cloud TPU에서도 최적화된 성능을 제공한다.

11명

추천인 목록보기

댓글 13

/ 1 페이지

다이아mond님의 댓글의 댓글

작성일

03.16 09:21

@셀빅아이님에게 답글

로컬에서 돌리신다는 말이죠?

LM Studio/Ollama 등을 사용해서 로컬에서 돌리신건가요?

LM Studio/Ollama 등을 사용해서 로컬에서 돌리신건가요?

셀빅아이님의 댓글의 댓글

작성일

03.16 09:32

@다이아mond님에게 답글

저 사양으로 로컬로 LM Studio로 4b모델 원활히 돌아갑니다.

신세계네요. :)

신세계네요. :)

집사C님의 댓글

작성자

집사C

집사C

집사C

집사C

작성일

03.16 11:53

Mac mini M1에서 gemma3:12b 복합 질문 체이닝 테스트시 약 3-5분 정도에 응답 을 주었고, 해당 결과는 gpt4.0 보다 조금 낮은 퀄리티 3.5보다는 쓸만한 결과 였습니다. (근거는 없습니다.)

ocr 테스트는 iPhone으로 찍은 사진 전송 후 분석하는 테스트를 진행 했는데 만족스럽지는 않았지만 apple에서 제공하는 ocr 결과 보다는 쓸만헀습니다.

한줄 총평: 12b 상당히 만족스럽습니다. 27b는 신형 Mac mini M4에서 돌아 갈것 같은데 혹 테스트 해보신분 계시면 결돠 공유 부탁드립니다.

ocr 테스트는 iPhone으로 찍은 사진 전송 후 분석하는 테스트를 진행 했는데 만족스럽지는 않았지만 apple에서 제공하는 ocr 결과 보다는 쓸만헀습니다.

한줄 총평: 12b 상당히 만족스럽습니다. 27b는 신형 Mac mini M4에서 돌아 갈것 같은데 혹 테스트 해보신분 계시면 결돠 공유 부탁드립니다.

1

1

이름모를잡초야님의 댓글

작성자

이름모를잡초야

이름모를잡초야

이름모를잡초야

이름모를잡초야

작성일

03.16 18:33

gemma 12b 모델을 돌려보니

회사의 1660 6G 에서는 3개 정도 질문에 답변하고 나면 터지던데

집의 3070 laptop 8G 에서 돌려보니 잘 되더군요

회사의 1660 6G 에서는 3개 정도 질문에 답변하고 나면 터지던데

집의 3070 laptop 8G 에서 돌려보니 잘 되더군요

셀빅아이님의 댓글의 댓글

작성일

03.16 21:40

@kungmo님에게 답글

젬마3 12b 3비트 양자화 모델 써봤는데 많이 느리네요.

딥시크보단 빠르지만요.

그래픽 카드 업글 하고 싶습니다. :)

딥시크보단 빠르지만요.

그래픽 카드 업글 하고 싶습니다. :)

이름모를잡초야님의 댓글의 댓글

작성일

03.16 20:40

@셀빅아이님에게 답글

그래요? 으흠;; 근데 8G에서 잘 되던데, 아마 질문/답변 양이 증가해서 컨텍스트가 더 쌓이면 그 때야 터지려나보네요.

셀빅아이님의 댓글

한글 출력 잘 되고, 간단하지만 이미지도 가능합니다.

간단히 쓰기에 좋네요.