메타, 멀티모달 라마 4 출시

페이지 정보

wera

wera

본문

메타는 혁신적인 Llama 4 시리즈를 공개하며, 텍스트, 이미지 및 비디오 처리를 아우르는 고급 기능으로 해당 분야를 혁신할 것으로 기대되는 본격적인 멀티모달 AI 모델을 선보였습니다. Tom's Guide에 따르면, 이 차세대 AI 모델은 향상된 추론 능력을 갖추고 AI 에이전트가 웹 브라우저 및 기타 도구를 사용할 수 있도록 하여 인공지능 기술에서 중요한 도약을 이룰 것으로 예상됩니다.

Llama 4 시리즈는 텍스트와 비전 토큰을 통합된 모델 백본에 원활하게 통합하는 획기적인 네이티브 멀티모달 아키텍처를 도입합니다. 초기 융합(early fusion)으로 알려진 이 혁신적인 접근 방식은 텍스트, 이미지 및 비디오를 포함한 다양한 데이터셋에 대한 사전 학습을 가능하게 합니다. 모델은 Mixture-of-Experts (MoE) 설계를 활용하며, 주어진 입력에 대해 전체 매개변수 중 일부만 활성화되어 훈련 및 추론 시 계산 효율성을 크게 향상시킵니다. 이러한 아키텍처 발전은 Llama 4 모델이 여러 모달리티를 동시에 처리하고 이해할 수 있도록 하여 다양한 도메인에서 더 정교한 AI 애플리케이션의 길을 열어줍니다.

2 소스들

라마 4 모델 사양

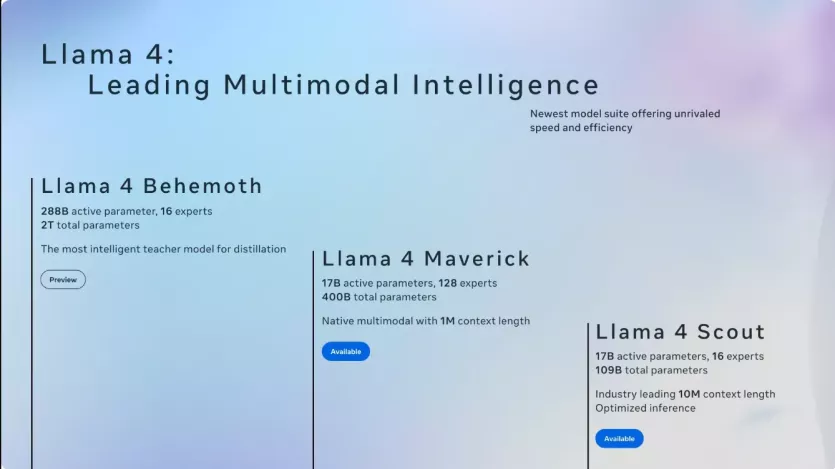

라마 4 시리즈는 각각 특정 사용 사례에 맞춘 세 가지 독특한 모델을 소개합니다. Llama 4 Scout는 170억 개의 활성 매개변수와 16개의 전문가를 갖춘 컴팩트한 모델로, 1천만 토큰 컨텍스트 윈도우를 자랑하며 광범위한 컨텍스트 분석이 필요한 작업에 이상적입니다. Llama 4 Maverick은 동일하게 170억 개의 활성 매개변수를 가지지만 128명의 전문가를 포함하며, 일반적인 어시스턴트 작업과 정밀한 이미지 이해에서 뛰어난 성능을 발휘합니다. 미리보기 버전인 Llama 4 Behemoth는 2,880억 개의 활성 매개변수와 거의 2조 개의 총 매개변수를 가진 거대한 교사 모델로, STEM 벤치마크에서 GPT-4.5 및 Claude Sonnet 3.7과 같은 선도적인 모델을 능가합니다.

2 소스들

훈련 혁신 및 성과

메타의 Llama 4 훈련 과정은 다양한 구성에서의 하이퍼파라미터 최적화를 위한 MetaP와 같은 혁신적인 기술을 포함했으며, 모델은 Llama 3 데이터셋 크기의 두 배인 30조 토큰으로 훈련되었습니다. 경량화된 지도 학습 미세 조정, 온라인 강화 학습, 직접 선호 최적화와 같은 고급 전략이 추론 및 다중 모달 기능을 향상시키기 위해 사용되었습니다. 벤치마크 테스트에서 Llama 4 Scout와 Maverick은 GPT-4o 및 Gemini 2.0 Pro와 같은 경쟁자를 코딩, 추론, 다국어 작업 및 이미지 벤치마크에서 능가하며, 더 작은 크기에도 불구하고 낮은 비용으로 우수한 결과를 제공했습니다.

2 소스들

라마 4의 접근성

항상 그랬듯이 오픈 소스로 제공되는 Llama 4 모델은 Hugging Face와 llama.com과 같은 인기 있는 플랫폼에서 쉽게 다운로드할 수 있습니다. 이러한 접근성은 Meta의 생태계로 확장되어 WhatsApp, Messenger, Instagram Direct와 같은 널리 사용되는 애플리케이션에 통합됩니다. 회사의 오픈 웨이트 아키텍처에 대한 헌신은 개발자들이 이러한 고급 모델에 쉽게 접근하고 활용할 수 있도록 하여 다양한 분야에서 혁신을 촉진하고 개인화된 AI 경험을 창출할 수 있게 합니다.

근데 이거 제 pc에 설치 될까요¿ ㄷ ㄷ ㄷ ㄷ

물음표가 꺼꾸로 나옵니다 ㅠㅠㅠㅠㅠ

쟘스님의 댓글의 댓글

언젠가... 되겠죠? ㅎㅎ

어머님의 댓글

어머

어머

칼쓰뎅님의 댓글

칼쓰뎅

칼쓰뎅

(그것도 젤 하급인 스카우트만...)

더불어 평가가 좀 안좋게 나오는거 같습니다;;;

곧 나올 qwen3에 기대가 더 큰거 같고요.

개내대래매배새님의 댓글

이제, local 에서 돌리면서 잡일 시키고 싶어지네요.

Gemma 3.1 이 가벼워져서 로컬에서 돌리는 가능성을 보여줬는데

라마도 기대해 봅니다