OpenAI, GPT-4o 발표

페이지 정보

본문

[OpenAI 공식 발표]

Hello, GPT-4o

https://openai.com/index/hello-gpt-4o/

GPT-4o("o"는 "omni"를 뜻함)는 훨씬 더 자연스러운 인간-컴퓨터 상호작용을 향한 한 걸음입니다.

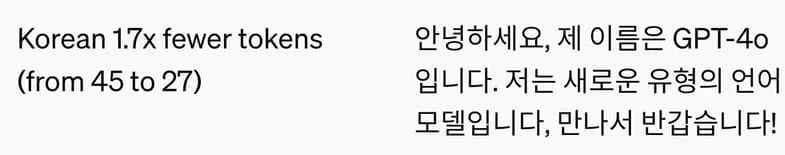

텍스트, 오디오, 이미지의 모든 조합을 입력으로 받아들이고, 모든 조합을 출력으로도 생성할 수 있습니다. 오디오 입력에는 최소 232밀리초, 평균 320밀리초 안에 응답할 수 있는데, 이것은 대화에서 사람의 반응 시간과 비슷합니다. 영어와 코드 분야에서는 GPT-4 Turbo 성능과 같지만, 비영어권 언어 텍스트에서는 상당한 개선을 보이면서 훨씬 더 빠르고 API는 50% 더 저렴합니다. GPT-4o는 특히 기존 모델보다 시각과 청각 이해 능력이 뛰어납니다. [중략]

GPT-4o의 텍스트와 이미지 기능은 오늘부터 ChatGPT에서 제공을 시작합니다. 저희는 GPT-4o를 무료 가입자도 사용할 수 있게 하고, Plus 사용자는 최대 5배 더 높은 메시지 제한을 제공합니다. 앞으로 몇 주 안에 ChatGPT Plus에서 GPT-4o를 사용한 새로운 버전의 음성 모드를 알파 버전으로 공개할 예정입니다.

개발자는 이제 API에서 GPT-4o를 텍스트와 비전 모델로 사용할 수 있습니다. GPT-4o는 GPT-4 Turbo와 비교하면 2배 더 빠르고, 가격은 절반이며, 속도 제한은 5배 더 높습니다. 앞으로 몇 주 안에 API에서 신뢰하는 소수 파트너부터 GPT-4o의 새로운 오디오와 비디오 기능 지원을 제공할 계획입니다.

덧붙이면, 얼마 전까지 LMSYS 챗봇 아레나에서 im-also-a-good-gpt2-chatbot 으로 표시되던 모델이라고 합니다.

https://twitter.com/LiamFedus/status/1790064963966370209

https://twitter.com/LiamFedus/status/1790064966000848911

https://twitter.com/LiamFedus/status/1790064967787413820

커피짱조아님의 댓글

내가뭐그렇지님의 댓글

영상통화? 하면서 누가 누군지 인식하고, 사물 인식하고, 대화 이해하고, 감정까지 섞어서 대답해주고, 농담이 아니라 HER 95%는 구현된거 같습니다. ㅎㅎ

가사라님의 댓글

조금 써봤는데, 빠릿해진거는 좋네요.

Coldtime124님의 댓글

실제 사용에서는 시연만큼 매끄럽거나 자연스럽지는 않습니다. 한 7~80%정도 느낌입니다.

그럼에도 혁신적이라는 건 부정할 수 없네요.

우선적으로 통역하시는 분들 입지가 많이 좁아질 것 같다는 생각이 들었습니다.

나무플러스님의 댓글

lmsys 에서 일주일 사용해보고,,,클로드3는 해지를 하게 되더라구여..

죽창깎는소년님의 댓글

역시 gpt2는 여기서 만든거군요..ㅎㅎ