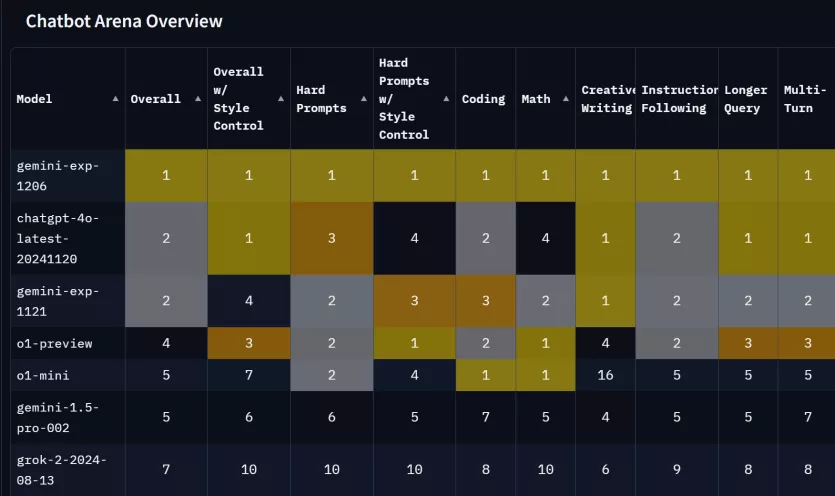

Gemini exp 1206 등장

알림

|

페이지 정보

작성일

2024.12.07 02:28

본문

댓글 11

/ 1 페이지

가사라님의 댓글의 댓글

@엉클머리님에게 답글

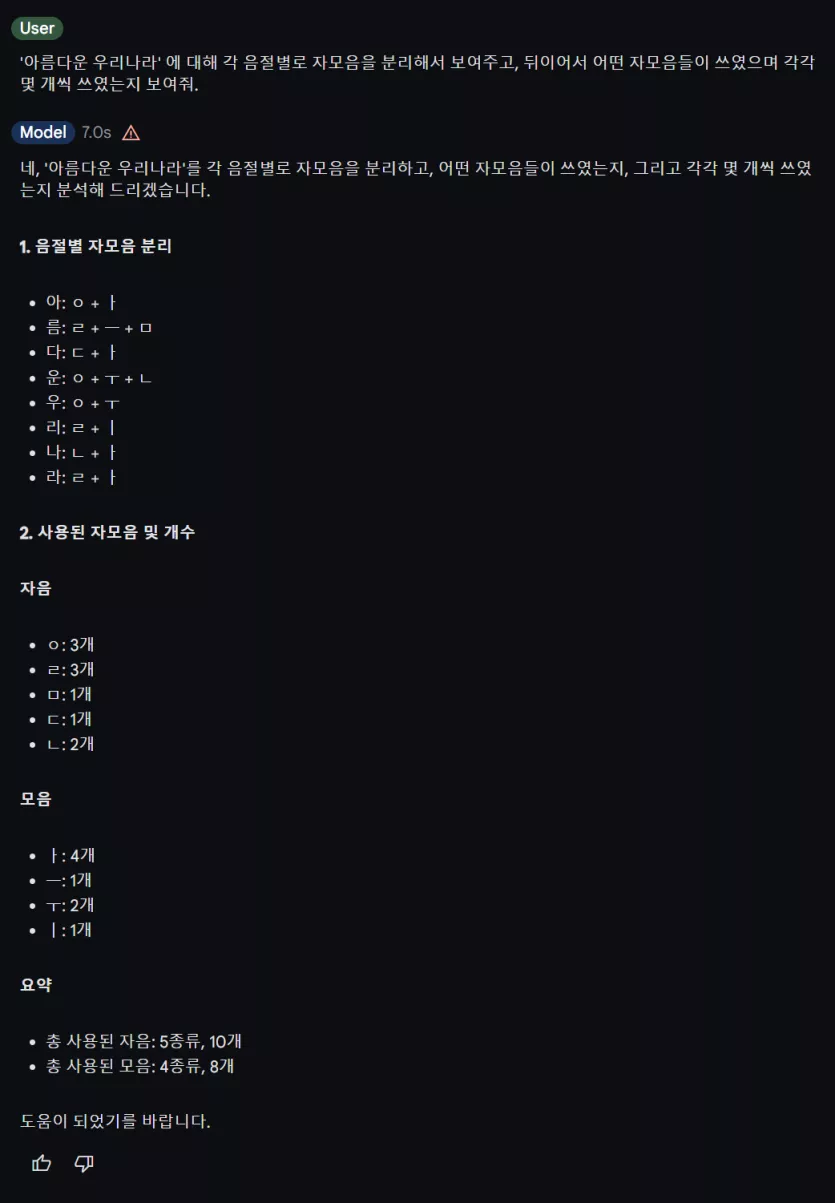

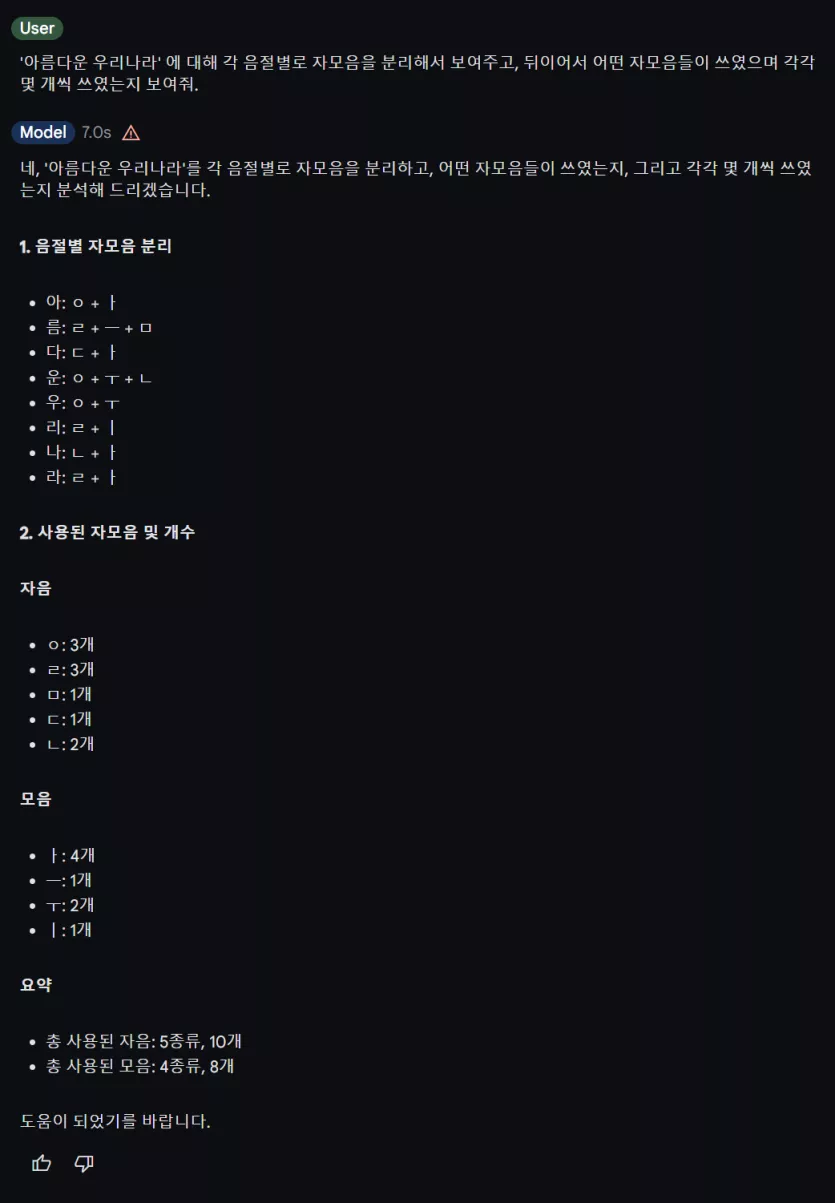

저도 같은 답변이 나오는걸 확인했는데, 이유를 물어보니 '름' 에 소리가 나지 않는 겹받침 ㅇ 이 있다고 답변하네요.

제가 '늠름' 에도 ㅇ 이 있냐고 되물어보니 그제서야 총 3개가 맞다고 제대로 다시 정정해줬습니다.

제가 평문으로 다음과 같이 프롬프트를 넣어보니 문제없이 잘 처리해주는데, 님이 쓰신 프롬프트나 제가 평문으로 쓴 같은 프롬프트를 GPT 4o 에게 했을 때는 틀린 답을 주는 걸로 봐서는 제가 본문에 쓴 대로 무료로 쓸 수 있는 LLM 중에서는 여전히 최고가 맞다고 생각합니다.

제가 '늠름' 에도 ㅇ 이 있냐고 되물어보니 그제서야 총 3개가 맞다고 제대로 다시 정정해줬습니다.

제가 평문으로 다음과 같이 프롬프트를 넣어보니 문제없이 잘 처리해주는데, 님이 쓰신 프롬프트나 제가 평문으로 쓴 같은 프롬프트를 GPT 4o 에게 했을 때는 틀린 답을 주는 걸로 봐서는 제가 본문에 쓴 대로 무료로 쓸 수 있는 LLM 중에서는 여전히 최고가 맞다고 생각합니다.

엉클머리님의 댓글의 댓글

@가사라님에게 답글

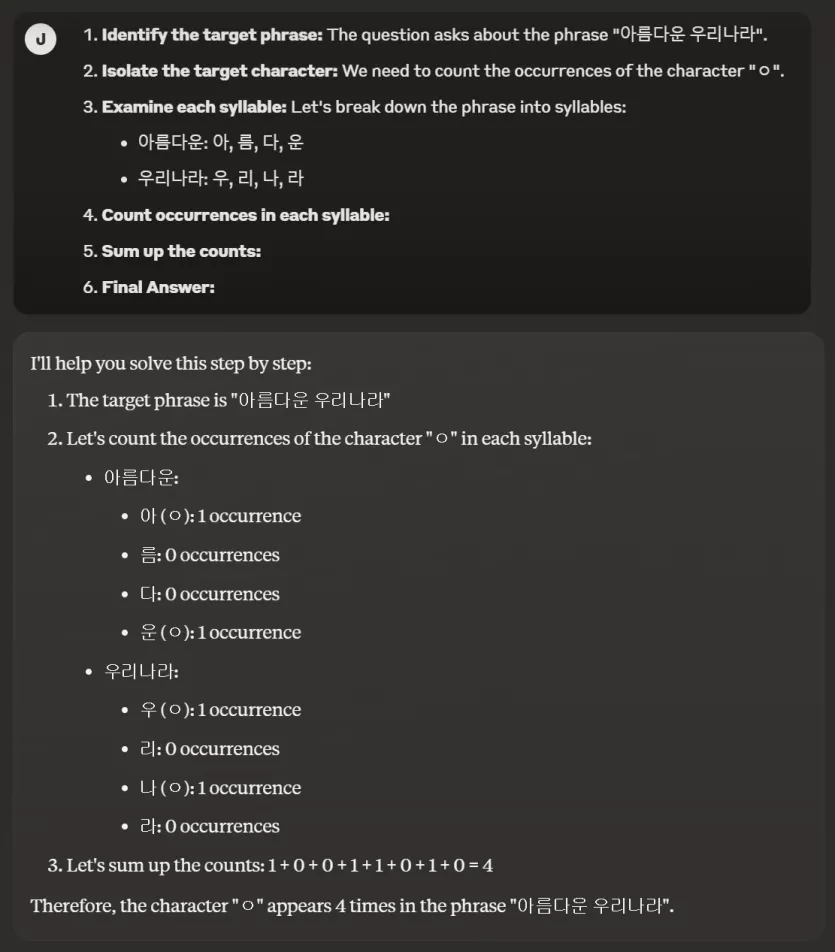

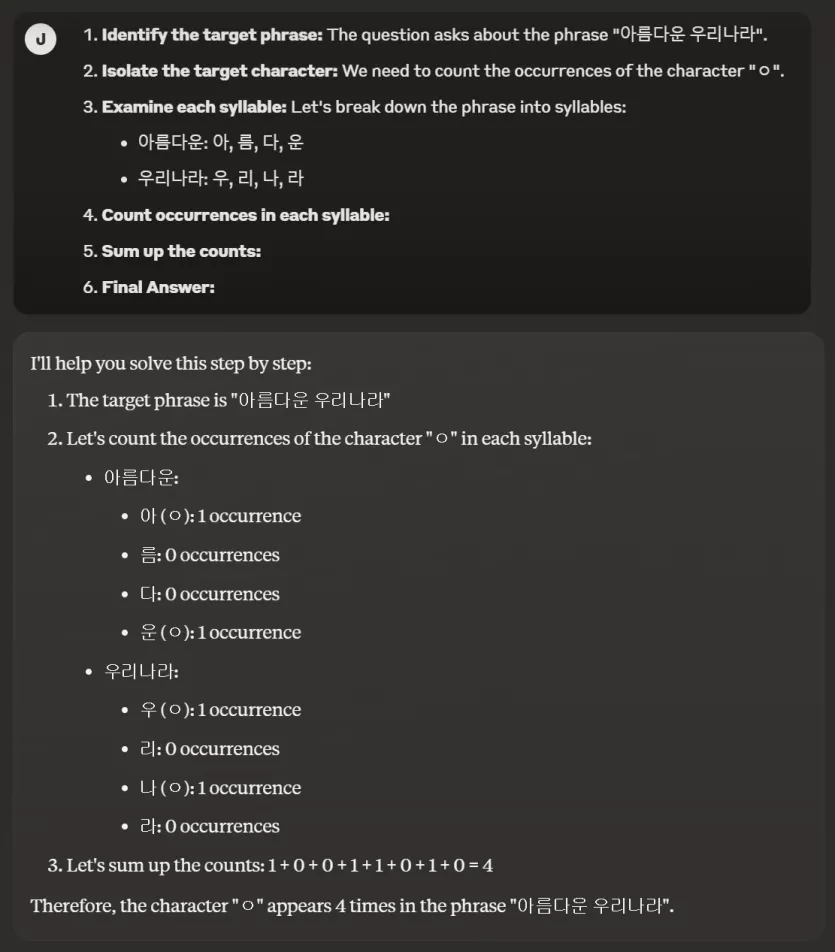

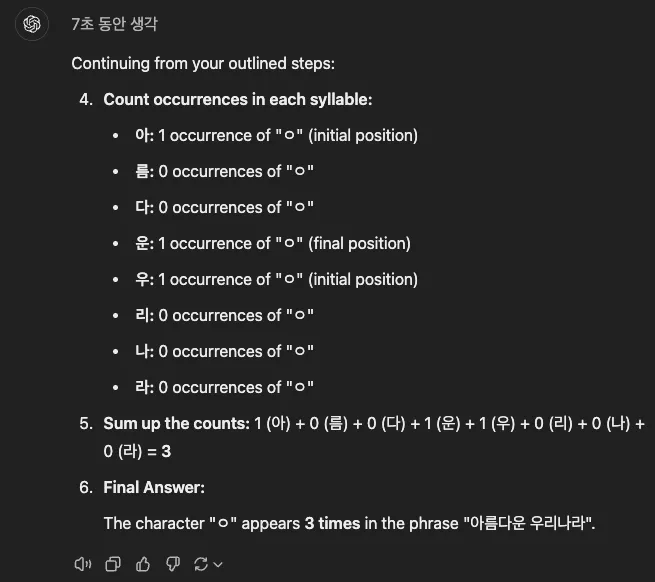

이 프롬프트는 프롬프트를 이해하는 추론 성능도 확인하려고 만든 것 중에 하나입니다. 단계적인 프롬프트틀 이해하는 능력을 시험합니다. 단순히 이응이 몇 개 있냐고 묻지 않은 이유입니다. 모델에게는 쉽지 않은 프롬프트입니다. Gemini 1.5 Pro도 이 문제를 첫 번째에 맞추지 못합니다. 제미나이의 특징으로 보여집니다. 한 세대 이전 모델인 Haiku 3.0은 단번에 맞춥니다. 그러나 흥미롭게도 Opus 3는 맞추지 못합니다. 즉 작업에 따라서 어울리는 적합한 모델이 따로 있습니다.

참고로, 4o도 Sonnet과 마찬가지로 API와 챗의 성능 차이가 있습니다. 이 프롬프트를 API로 여러번 테스트해서 균일한 답을 얻지 못하면 해당 모델이 복잡한 프롬프트에 대한 균일성이 부족하다고 여깁니다.

댓글이 길어졌습니다.

# 프롬프트

1. **Identify the target phrase:** The question asks about the phrase "아름다운 우리나라".

2. **Isolate the target character:** We need to count the occurrences of the character "ㅇ".

3. **Examine each syllable:** Let's break down the phrase into syllables:

- 아름다운: 아, 름, 다, 운

- 우리나라: 우, 리, 나, 라

4. **Count occurrences in each syllable:**

5. **Sum up the counts:**

6. **Final Answer:**

참고로, 4o도 Sonnet과 마찬가지로 API와 챗의 성능 차이가 있습니다. 이 프롬프트를 API로 여러번 테스트해서 균일한 답을 얻지 못하면 해당 모델이 복잡한 프롬프트에 대한 균일성이 부족하다고 여깁니다.

댓글이 길어졌습니다.

# 프롬프트

1. **Identify the target phrase:** The question asks about the phrase "아름다운 우리나라".

2. **Isolate the target character:** We need to count the occurrences of the character "ㅇ".

3. **Examine each syllable:** Let's break down the phrase into syllables:

- 아름다운: 아, 름, 다, 운

- 우리나라: 우, 리, 나, 라

4. **Count occurrences in each syllable:**

5. **Sum up the counts:**

6. **Final Answer:**

칼쓰뎅님의 댓글의 댓글

@엉클머리님에게 답글

우리나라 글자같은 조립식? 에 대한 데이터셋이 좀 부족해서 생긴일 아닐까요 ㅎㅎ

가사라님의 댓글의 댓글

@엉클머리님에게 답글

haiku 에서 잘 된다고 하셔서 방금 똑같이 물어봤는데 haiku 는 '나'에 'ㅇ'이 있다고 생각하네요.

그래서, 제가 Why do you think '나' contains 'ㅇ'? 라고 물어보니 다시 올바르게 정정을 해주는군요.

(새 창을 열어서 총 3번 물어봤는데 모두 '나'에서 문제가 발생합니다.)

아마 모델넘버링은 유지한채 모델이 교체되었을지도 모르겠네요.

사실 LLM 이 때때로 틀린 답변을 하는 것은 자연스러운 현상이라고 생각합니다.

그래서 프롬프팅이 중요한거고 재확인을 효율적으로 수행하는 것이 중요한거겠죠.

다만, 저는 프롬프트 엔지니어링이 필요한 시장과 아닌 시장으로 나뉠 것으로 예측하기 때문에 광대한 범위에서의 다양한 평문으로 질문하는 경우들에 대해 답변을 잘 하는 것도 매우 중요하게 생각합니다.

머지않아 에이전트들끼리도 대화하는 세상이 올건데 이런 시장에서는 정형데이터로 답해달라거나 추론지시에 얼마나 잘 따라주는지를 체크하는 것이 얼마나 의미가 있을까 싶거든요.

haiku 에서 잘 된다고 하셔서 방금 똑같이 물어봤는데 haiku 는 '나'에 'ㅇ'이 있다고 생각하네요.

그래서, 제가 Why do you think '나' contains 'ㅇ'? 라고 물어보니 다시 올바르게 정정을 해주는군요.

(새 창을 열어서 총 3번 물어봤는데 모두 '나'에서 문제가 발생합니다.)

아마 모델넘버링은 유지한채 모델이 교체되었을지도 모르겠네요.

사실 LLM 이 때때로 틀린 답변을 하는 것은 자연스러운 현상이라고 생각합니다.

그래서 프롬프팅이 중요한거고 재확인을 효율적으로 수행하는 것이 중요한거겠죠.

다만, 저는 프롬프트 엔지니어링이 필요한 시장과 아닌 시장으로 나뉠 것으로 예측하기 때문에 광대한 범위에서의 다양한 평문으로 질문하는 경우들에 대해 답변을 잘 하는 것도 매우 중요하게 생각합니다.

머지않아 에이전트들끼리도 대화하는 세상이 올건데 이런 시장에서는 정형데이터로 답해달라거나 추론지시에 얼마나 잘 따라주는지를 체크하는 것이 얼마나 의미가 있을까 싶거든요.

엉클머리님의 댓글의 댓글

@가사라님에게 답글

클로드는 시간에 따라 답변의 편차가 큰 문제가 있습니다. API 조차도. 이 문제로 레딧에서 성토하는 유저가 많고, 시간대별로 성능이 다르다는 사실을 암암리(?) 이용하는 유저들도 보입니다. 지금은 저도 틀린 답을 얻었습니다.

엉클머리님의 댓글

가사라님의 댓글의 댓글

@엉클머리님에게 답글

ㅎㅎ

사실 이런 테스트에는 큰 관심이 없습니다.

엉클머리님께서 테스트하신 것에 대해 확인을 해봤을 뿐입니다.

제 관심사는 무료(혹은 거의)로 쓸 수 있는 클라우드 LLM 을 통해 다자간 자연스러운 정보흐름이 일어나는 것에 있습니다.

사실 이런 테스트에는 큰 관심이 없습니다.

엉클머리님께서 테스트하신 것에 대해 확인을 해봤을 뿐입니다.

제 관심사는 무료(혹은 거의)로 쓸 수 있는 클라우드 LLM 을 통해 다자간 자연스러운 정보흐름이 일어나는 것에 있습니다.

엉클머리님의 댓글의 댓글

@가사라님에게 답글

관심은 없으신데 테스트는 해보셨습니다 ;) 이 건 테스트 시트의 한 개 문항일 뿐입니다. 관심사에 적합한 테스트 문항을 작성해가면서 적합한 모델을 선별해갑니다.

엉클머리님의 댓글

방금 발표된 Gemini 2.0 Flash 사용한 결과입니다.

Okay, let's break down the phrase "아름다운 우리나라" and count the occurrences of the character "ㅇ".

1. **Target Phrase:** 아름다운 우리나라

2. **Target Character:** ㅇ

3. **Syllable Breakdown:**

- 아름다운: 아-름-다-운

- 우리나라: 우-리-나-라

4. **Counting Occurrences in Each Syllable:**

- 아름다운:

- 아: **ㅇ** (1)

- 름: 0

- 다: 0

- 운: **ㅇ** (1)

- 우리나라:

- 우: **ㅇ** (1)

- 리: 0

- 나: 0

- 라: 0

5. **Summing the Counts:**

- 아름다운: 1 + 0 + 0 + 1 = 2

- 우리나라: 1 + 0 + 0 + 0 = 1

- Total: 2 + 1 = 3

6. **Final Answer:** The character "ㅇ" appears 3 times in the phrase "아름다운 우리나라".

Okay, let's break down the phrase "아름다운 우리나라" and count the occurrences of the character "ㅇ".

1. **Target Phrase:** 아름다운 우리나라

2. **Target Character:** ㅇ

3. **Syllable Breakdown:**

- 아름다운: 아-름-다-운

- 우리나라: 우-리-나-라

4. **Counting Occurrences in Each Syllable:**

- 아름다운:

- 아: **ㅇ** (1)

- 름: 0

- 다: 0

- 운: **ㅇ** (1)

- 우리나라:

- 우: **ㅇ** (1)

- 리: 0

- 나: 0

- 라: 0

5. **Summing the Counts:**

- 아름다운: 1 + 0 + 0 + 1 = 2

- 우리나라: 1 + 0 + 0 + 0 = 1

- Total: 2 + 1 = 3

6. **Final Answer:** The character "ㅇ" appears 3 times in the phrase "아름다운 우리나라".

엉클머리님의 댓글