DeepSeek R1 이 OpenAI o1 에 필적하는 성능을 내네요.

페이지 정보

본문

방금 o1 으로 잘 안풀려서 꽤 오랫동안 시간을 끌었던 추론문제를 하나 시켜봤는데 꽤 근사하게 잘 풀어내네요.

70초 정도 걸려서 1차 답변주고 제가 잘못된거 하나 지적했더니 또 70초 정도 다시 생각해서 정답을 내주네요.

o1 보다 더 빨리 풀었는데 문제 하나만으로는 판단하기 그렇지만 다음 영상의 유튜버도 벤치마크 성능상 o1 에 필적한다고 평가하는군요.

https://www.youtube.com/watch?v=_KRKqLaVYQU

중국에서 o1 의 추론방법을 알아냈다는 소식이 얼마전에 있었는데 그새 그것도 오픈소스로 만들어서 풀어버릴 줄은 몰랐습니다.

API 사용료도 엄청나게 저렴하고요.

이전 V3 모델만 해도 간간히 중국어를 내뱉어서 쓰기가 좀 그랬는데 추론성능만 보면 R1 은 앞으로 애정하게 될 듯 합니다.

다음 주 정도에 OpenAI 에서 o1 이상의 성능을 낸다고 알려진 o3-mini 를 내놓는다고는 하던데 API 가격이 관건이 될 거 같습니다.

역시 중국은 디플레이션을 수출하는 나라답네요.

DeekSeek R1 은 다음 URL 에 가서 DeepThink 버튼을 활성화하면 됩니다.

다음은 DeepSeek 의 X 에 게시된 벤치마크 자료하고 유튜브 영상을 Gemini 2.0 Flash exp 로 요약한 내용입니다.

---

DeepSeek R1 모델 상세 요약

소개

DeepSeek R1 모델은 OpenAI의 o1 모델과 대등한 성능을 가진 오픈 소스 추론 모델입니다.

모델 가중치를 포함한 모든 것이 MIT 라이선스로 완전 오픈 소스이며, 호스팅 버전 사용 시 o1 모델보다 훨씬 저렴합니다.

오픈 소스 모델이 폐쇄형 모델보다 3~6개월 뒤쳐져 있었으나, DeepSeek R1은 o1 모델 출시 3개월 만에 오픈 소스 버전으로 출시되었습니다.

오픈 소스 모델 개발의 가능성을 보여주는 사례로, 향후 유사한 오픈 소스 추론 모델이 많이 등장할 것으로 예상됩니다.

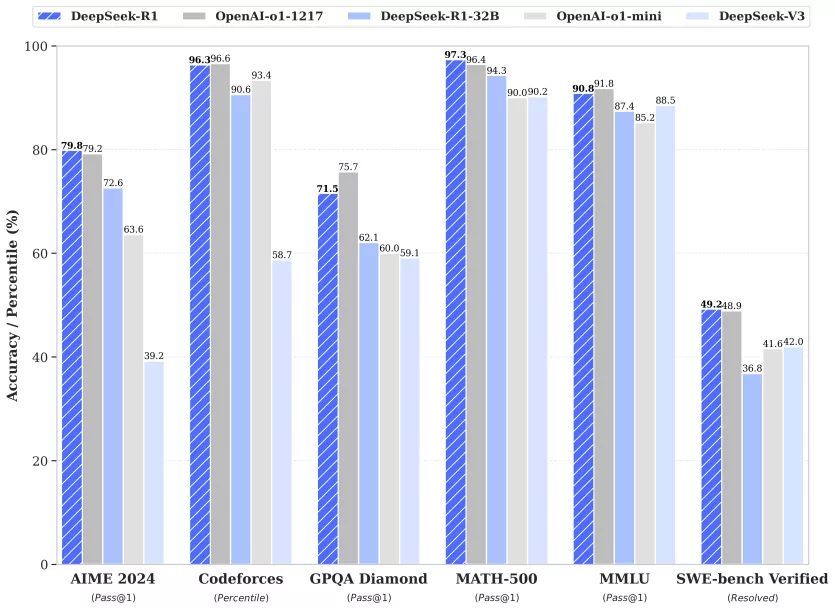

벤치마크 성능 비교

**DeepSeek R1 (진한 파란색)**은 여러 벤치마크에서 OpenAI o1(진한 회색)과 유사하거나 더 나은 성능을 보입니다.

AIM 2024 벤치마크에서는 OpenAI o1을 능가합니다.

Codeforces에서는 거의 동등한 수준입니다.

GPQA Diamond에서는 OpenAI o1보다 약간 떨어지지만 근접한 성능을 보여줍니다.

Math 500에서는 OpenAI o1을 능가하며, MMLU와 SWE 벤치마크에서는 약간 뒤쳐지지만 매우 근접한 수준입니다.

**DeepSeek R1 32B (연한 파란색)**은 OpenAI o1 mini (연한 회색)와 비교됩니다.

**DeepSeek V3 (가장 연한 파란색)**는 추론 능력이 없는 모델입니다.

Claude의 최첨단 모델 및 GPT-4o와의 비교:

Claude 모델과의 비교에서는 SWE Verified 코딩 벤치마크를 제외하고 대부분의 항목에서 DeepSeek R1이 우위를 점합니다.

GPT-4o와의 비교에서는 모든 항목에서 DeepSeek R1이 우수한 성능을 보입니다.

주요 특징 및 라이선스

완전 오픈 소스: 모델 가중치, 기술 논문, 모든 코드가 공개되어 있습니다.

MIT 라이선스: 자유로운 배포, 수정, 상업적 이용이 가능합니다.

상업적 사용 가능: DeepSeek R1을 이용하여 자유롭게 제품 개발 및 서비스 제공이 가능합니다.

저렴한 가격: API 사용 가격이 OpenAI o1 모델 대비 훨씬 저렴합니다.

모델의 성능 및 특징

체인 오브 소트 (Chain of Thought) 추론: 모델의 사고 과정을 볼 수 있어, 모델이 어떻게 답을 도출하는지 확인할 수 있습니다.

인간적인 사고 방식: 모델이 추론 과정에서 "Okay", "hmm", "let's think"와 같은 인간과 유사한 표현을 사용합니다.

자기 수정 능력: 답변 과정에서 스스로 오류를 수정하는 모습을 보입니다.

복잡한 문제 해결 능력: 마블 퀴즈와 같이 복잡한 문제에 대해 체계적으로 분석하고 해결합니다.

미묘한 언어 이해: "apple"로 끝나는 문장 생성과 같은 언어적 미묘함을 요구하는 작업에서 뛰어난 성능을 보입니다.

모델의 학습 방식

강화 학습: 인간의 피드백 없이 강화 학습을 통해 스스로 학습합니다.

알파고 기법: 순수 강화 학습을 통해 다양한 시도를 통해 학습을 진행합니다.

그룹 상대 정책 최적화 (Group Relative Policy Optimization): 비평 모델 없이 후보 결과를 기반으로 최적의 답변을 찾습니다.

사고 시간 할당: 문제에 따라 스스로 사고 시간을 할당하는 능력이 있습니다.

주요 인용 문장

"이제 다른 오픈 소스 회사들이 그것이 가능하다는 것을 알게 되었고, 어떻게 그것을 달성하는지에 대한 로드맵을 공개했기 때문에, 이러한 오픈 소스 추론 모델의 홍수를 보게 될 것입니다."

"DeepSeek R1은 문제에 더 많은 사고 시간을 할당하기 위해 초기 접근 방식을 재평가하는 법을 배웁니다."

"이러한 행동은 모델의 성장하는 추론 능력을 입증할 뿐만 아니라 강화 학습이 어떻게 예상치 못하고 정교한 결과로 이어질 수 있는지를 보여주는 매력적인 예시입니다."

"문제를 푸는 방법을 명시적으로 가르치는 대신 적절한 인센티브를 제공하면 고급 문제 해결 전략을 자율적으로 개발합니다."

결론

DeepSeek R1은 오픈 소스 AI 모델의 가능성을 보여주는 중요한 모델입니다.

강력한 성능, 저렴한 비용, 개방적인 접근 방식으로 AI 기술의 접근성을 높이는 데 기여할 것으로 예상됩니다.

모델을 직접 다운로드하고 사용해 볼 것을 권장합니다.

향후 DeepSeek R1 기술 논문에 대한 자세한 분석 비디오를 제공할 예정입니다.