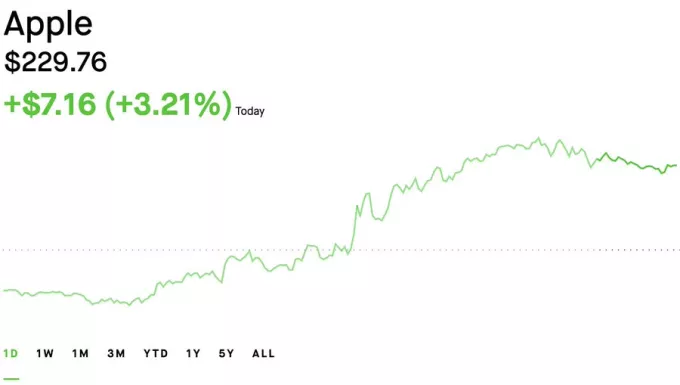

(펌) 왜 DeepSeek가 Apple에 호재인가?

페이지 정보

코미

코미

본문

다음은 현재 시장에서 DeepSeek V3 및 R1을 실행할 수 있는 칩의 분석입니다:

NVIDIA H100: 80GB @ 3TB/s, $25,000, GB당 $312.50

AMD MI300X: 192GB @ 5.3TB/s, $20,000, GB당 $104.17

애플 M2 울트라: 192GB @ 800GB/s, $5,000, $26.04(!!) GB당

Apple의 M2 Ultra(2023년 6월 출시)는 AMD MI300X보다 메모리 단위당 4배 더 비용 효율적이며 NVIDIA H100보다 12배 더 비용 효율적입니다!

왜 이것이 DeepSeek과 관련이 있는가?

DeepSeek V3/R1은 총 671B 매개변수를 가진 MoE 모델이지만, 토큰이 생성될 때마다 37B만 활성화됩니다. 토큰을 생성할 때 어떤 37B가 활성화될지 정확히 알지 못하므로, 모두 고속 GPU 메모리에 준비되어 있어야 합니다.

37B 활성 매개변수를 로드하기에는 너무 느리기 때문에 일반 시스템 RAM을 사용할 수 없습니다(<1 tok/sec). 반면에 GPU는 빠른 메모리를 가지고 있지만 GPU 메모리는 비싸다. 그러나 Apple Silicon은 Unified Memory와 UltraFusion을 사용하여 다이를 융합합니다 - 저렴한 비용으로 많은 양의 중간-고속 메모리를 선호하는 절충안입니다.

통합 메모리는 각각에 대해 별도의 메모리를 갖는 것이 아니라 CPU와 GPU 간에 단일 메모리 풀을 공유합니다. CPU와 GPU 사이에 별도의 메모리와 복사 데이터를 가질 필요가 없습니다.

UltraFusion은 두 개의 다이를 초고속, 저지연 연결(2.5TB/s)으로 연결하는 Apple의 독점 상호 연결 기술입니다. 애플의 M2 울트라는 말 그대로 두 개의 애플 M2 맥스 다이가 울트라퓨전과 함께 융합된 것이다. 이것이 바로 애플이 이렇게 많은 양의 메모리(192GB)와 메모리 대역폭(800GB/s)을 달성할 수 있게 해주는 것이다.

애플 M4 울트라는 두 개의 M4 맥스 다이를 함께 융합하기 위해 동일한 울트라퓨전 기술을 사용한다는 소문이 있다. 이것은 M4 Ultra 256GB(!!)를 줄 것이다 통합 메모리 @ 1146GB/s. 이 중 두 개는 DeepSeek V3/R1 (4비트)을 57 tok/sec로 실행할 수 있습니다.

누가 최고의 AI 모델을 만들 것인지는 분명하지 않지만, AI는 애플 실리콘의 미국 하드웨어에서 실행될 것으로 보입니다.

https://x.com/alexocheema/status/1884017521985995178

이 포스트를 애플 번역을 이용하여 올립니다.

가랑비님의 댓글의 댓글

국내에도 나름 괜찮은 AI chip 메이커가 있는데, user friendly 한 API 가 약해서

general 한 용도보다는 벤더에 특화된 API 를 제공하고 지원하는게 주력인 듯 싶더군요.

CUDA 도 1~2년이 아니라, 연혁이 무지하게 쌓인 플랫폼?이어서, 넘어서거나 근접하기 쉽지 않아 보이네요.

DRJang님의 댓글의 댓글

(근데 그 분들에게 "이걸로 이렇게 하면 쩐다?"를 시전해 버렸으니............)

금오키도키님의 댓글

금오키도키

금오키도키

달짝지근님의 댓글