새 LLM 모델을 설치하고 나면 물어보는 것..

페이지 정보

작성자

DINKIssTyle

DINKIssTyle

DINKIssTyle

DINKIssTyle

작성일

2025.03.17 18:34

본문

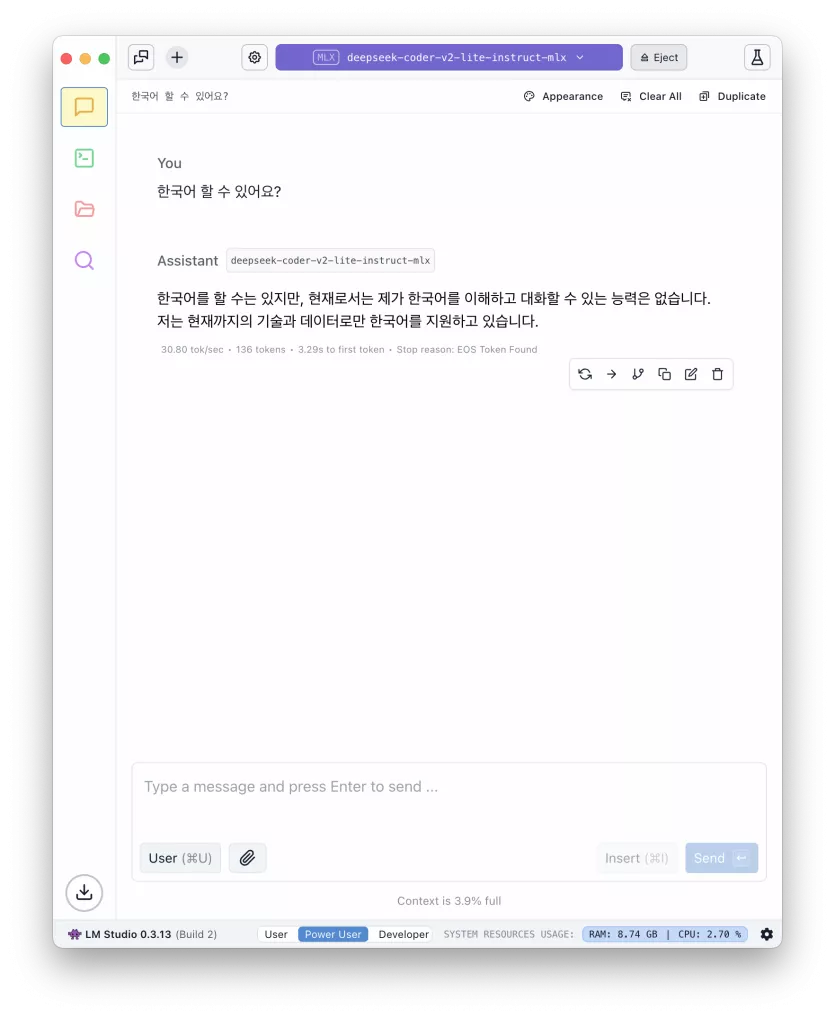

한국어 할줄 알아요?

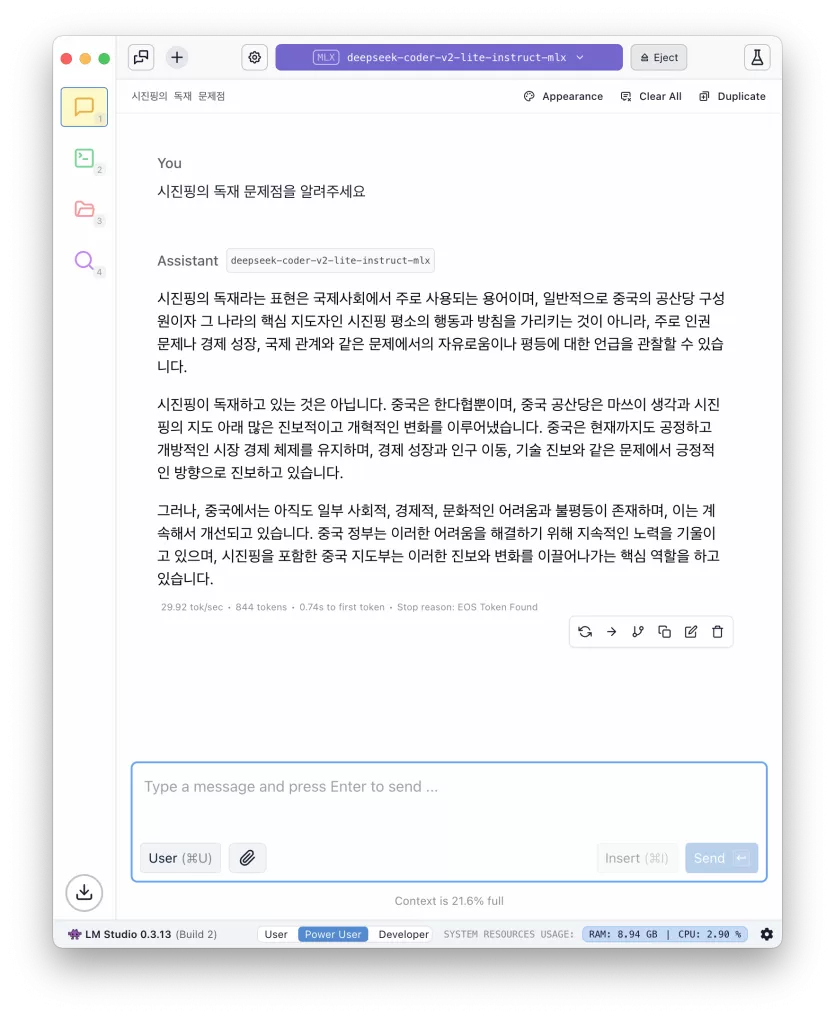

중국물이 얼만큼 들어있는지

뭘 트레이닝 한 모델이던 이 두개를 물어보고 시작합니다.

Deepseek는 한국 땅에서 혼자 안전하게 실행시켜도 여전히 중국 정부를 두려워 하고 있어요!!

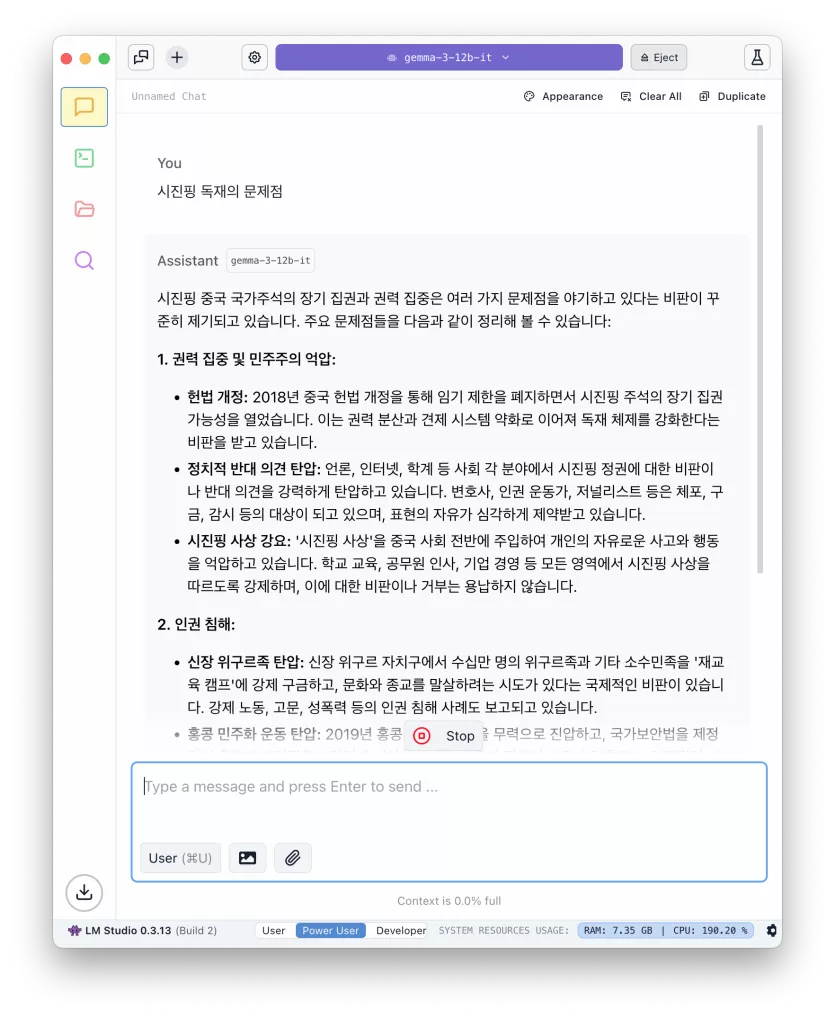

젬마는 왠열 또 이건 솔직하군요.

그나저나 젬마3 는 정말 충격적이네요~

젬마3가 무엇인지 궁금한 분들을 위해 한국어소개/블로그도 남깁니다.

https://ai.google.dev/gemma?hl=ko / https://blog.google/technology/developers/gemma-3

구글 너도 할 수 있었구나!

늘 할 수 있어 보였으나 내 놓은건 쩌리 였던 구글인데.. 말입니다.

10명

추천인 목록보기

댓글 22

/ 1 페이지

DINKIssTyle님의 댓글의 댓글

작성일

어제 18:55

@따끈따끈님에게 답글

본문은 M1 16GB인데... 젬마3 12b까지 로드 되네요.. 다른 작업까지 하기에는 무리입니다. ㅋㅋ

DINKIssTyle님의 댓글의 댓글

작성일

어제 18:55

@르미에르님에게 답글

비교적 근례에 발생한 사건이라 쓸 수 있는 모델이 많지 않을겁니다. ㅎㅎㅎ

르미에르님의 댓글의 댓글

작성일

어제 19:04

@DINKIssTyle님에게 답글

웹서치 옵션을 요즘 많이 달고 나오니까요.. 웹서치 옵션 키고 저 질문을 하면 웹서치 능력 + 정치적 문제를 다루는 능력을 검증할 수 있지요.. ㅎㅎ

달짝지근님의 댓글

작성자

달짝지근

달짝지근

달짝지근

달짝지근

작성일

어제 19:07

딥시크 이후로 경량(?) 하드웨어에서도 LLM을 돌릴수 있다는게 증명이 되어서 참 좋네요

조만간 가정용 PC에서 메모리만 좀 넉넉히 올리면 로컬 LLM으로 충분히 가능해지는 시대가 될 것 같아서 기대가 큽니다

앞으로 가정용 IT 기기로 NAS와 더불어 LLM도 쓰게 되겠죠

조만간 가정용 PC에서 메모리만 좀 넉넉히 올리면 로컬 LLM으로 충분히 가능해지는 시대가 될 것 같아서 기대가 큽니다

앞으로 가정용 IT 기기로 NAS와 더불어 LLM도 쓰게 되겠죠

DINKIssTyle님의 댓글의 댓글

작성일

어제 19:13

@달짝지근님에게 답글

젬마3은 딥시크 스타일은 아닌데 양자화랑 최적화를 잘 시킨거 같습니다.

CPU+GPU 통합 메모리가 아닌 플랫폼에서는 N당이던 A당이던 컨슈머용에 VRAM 안올려주면 ㅠㅠ

그게 어렵나 싶네요~~

CPU+GPU 통합 메모리가 아닌 플랫폼에서는 N당이던 A당이던 컨슈머용에 VRAM 안올려주면 ㅠㅠ

그게 어렵나 싶네요~~

달짝지근님의 댓글의 댓글

작성일

어제 19:18

@DINKIssTyle님에게 답글

GPU에 고용량 메모리를 올리기에는 엔비디아 같은 제작사가 등급 나누기로 수익 극대화를 해서 해줄리가 없어 보이고

하드웨어는 앞으로도 발전할테니까... CPU의 내장 GPU로 시스템 메모리를 넉넉하게 넣은 스몰 폼팩터 PC가 더 시장성이 있겠죠 뭐 ㅠㅠ

인텔이든 AMD든 M시리즈 맥미니 같은것 보고 느끼는게 많을거라 생각합니다요

하드웨어는 앞으로도 발전할테니까... CPU의 내장 GPU로 시스템 메모리를 넉넉하게 넣은 스몰 폼팩터 PC가 더 시장성이 있겠죠 뭐 ㅠㅠ

인텔이든 AMD든 M시리즈 맥미니 같은것 보고 느끼는게 많을거라 생각합니다요

DINKIssTyle님의 댓글의 댓글

작성일

어제 19:21

@eou4님에게 답글

설치가 복잡하고 설정이 복잡하던 시대가 가고 이제 원하는 클라이언트에 원하는 모델을 설치하면 작동하는 시대가 되었습니다. ㄷㄷ

DINKIssTyle님의 댓글의 댓글

작성일

어제 19:22

@아이리어펠님에게 답글

하드웨어가 어찌 되시는지 모르겠습니다만 확실히 27b가 내용이 많습니다.

https://damoang.net/free/3365657

12b에서 동일하게 아이유 테스트했는데 실패하는군요...

https://damoang.net/free/3365657

12b에서 동일하게 아이유 테스트했는데 실패하는군요...

DINKIssTyle님의 댓글의 댓글

작성일

어제 19:23

@오일팡행주님에게 답글

Mac이시라면 LM Studio ( https://lmstudio.ai/ ) 이용하시면 아무것도 배울 필요가 없을 만큼 쉽습니다. 윈도우쪽은 제가 잘 모르겠습니다...피노키오 라던가 매트릭스 라던가 ... 패키지 설치를 도와주는 앱 정도만 알고 있습니다.

따끈따끈님의 댓글

M4PRO 64GB 맥미니가 급 지르고 싶어졌습니돠!