컴퓨터에 로컬 LLM 'Gemma3' 설치하고, iOS에서 사용하기

페이지 정보

작성자

DINKIssTyle

DINKIssTyle

DINKIssTyle

DINKIssTyle

작성일

2025.04.27 13:25

본문

LM Studio 를 설치합니다.

원하는 모델을 설치하셔도 되지만,

한국어도 잘하고 로컬 LLM 중 최고의 품질을 보여주는 Google의 Gemma3가

QAT 된 모델이 올라와서 더 저상양에서 더 빨라진 성능을 보여주고 있습니다.

제가 사용한 컴퓨터는 라이젠5 5600에 16GB 램, 라데온 RX 5700XT 8GB 입니다.

이 컴퓨터에 gemma-3-4B-it-QAT 를 사용했습니다.

LM Studio의 좌측 툴바에서 두번째 'Developer'에 들어가면,

이 토글 스위치로 서버를 켜고 끌 수 있습니다.

그 옆에는 서버 옵션이 있는데요, Serve on Local Network 를 켜주셔야 설치 된 컴퓨터의 외부에서도 사용 가능합니다.

사용하실 포트를 설정하시고, 공유기에서 외부에서 접근 가능하게 포트포워딩을 해주세요.

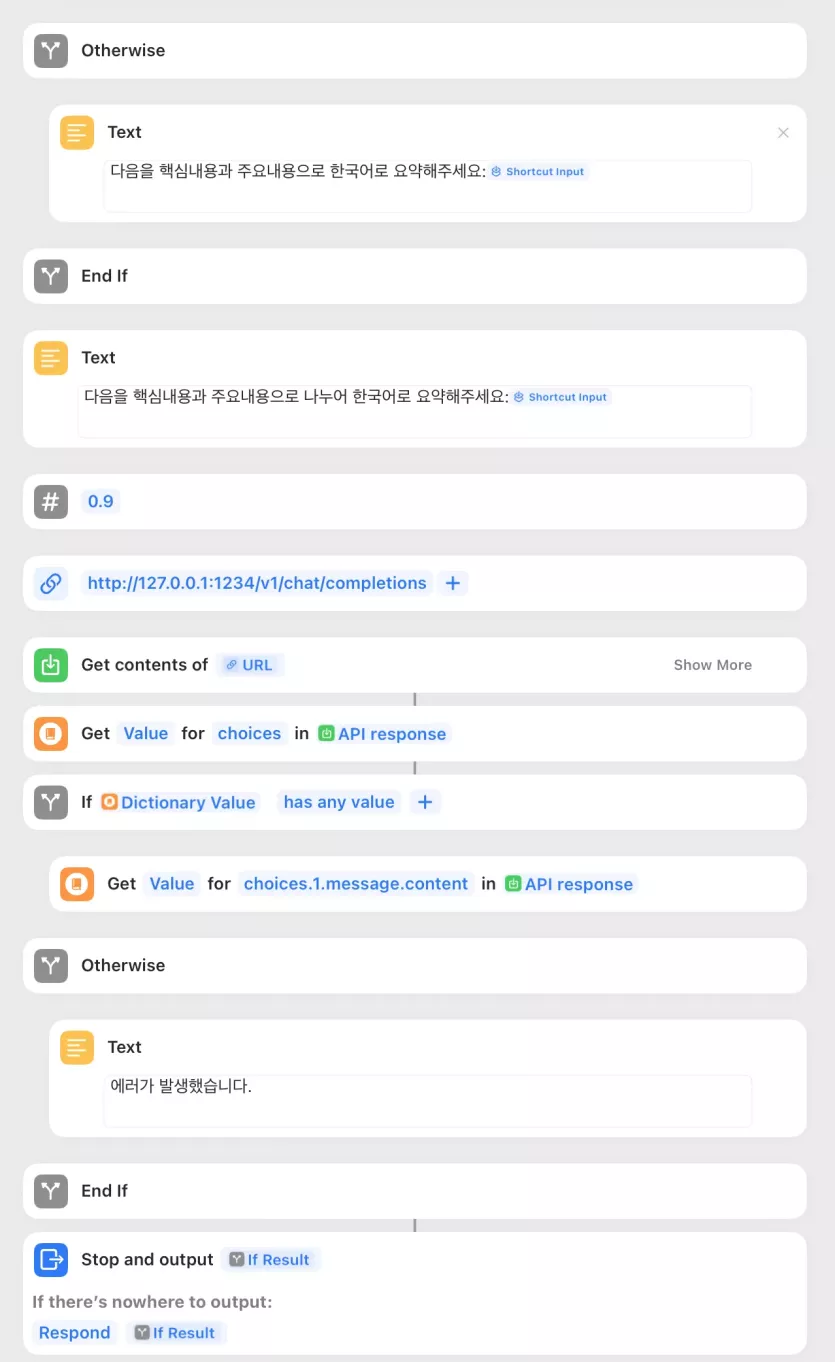

iOS용 단축어 예제는 아래에 만들어 두었습니다.

https://www.icloud.com/shortcuts/2971430e78b54a3fa6866345c1f587cc

공유항목이 http 로 시작하면 사파리에서 기사 읽기로 만들어 텍스트만 보내 요약 번역하고,

그냥 텍스트인 경우에는 그대로 받아 요약 번역 하는 단축어입니다.

예제는 예제일 뿐 중요한 부분은 처리 부분이기 때문에..

127.0.01:1234 이 부분을 실제 LM Studio 서버가 구동중인 주소로 변경하시고

응용해보시면 되겠습니다.

사용 장면 - 1배속

1. 웹사이트를 통째로 요청하기

2. 선택 된 텍스트 요청하기

13명

추천인 목록보기

댓글 3

/ 1 페이지

도시님의 댓글

작성자

도시

도시

도시

도시

작성일

04.27 18:07

좋은 강좌 감사합니다.

이제 NAS가 아니라 AI Server를 집에다 설치해놔야 되는 시대가 오겠군요. 개인정보 보호를 위해서는 외부 서버보다 집에다 놔두는 것이 좋겠죠. Video Ram 용량 크고 확장도 가능한 별도의 AI 가속기 같은 장치가 가격 좋게 나왔으면 하는 바램도 있네요.

이제 NAS가 아니라 AI Server를 집에다 설치해놔야 되는 시대가 오겠군요. 개인정보 보호를 위해서는 외부 서버보다 집에다 놔두는 것이 좋겠죠. Video Ram 용량 크고 확장도 가능한 별도의 AI 가속기 같은 장치가 가격 좋게 나왔으면 하는 바램도 있네요.

예지님의 댓글의 댓글

작성일

04.29 23:34

@도시님에게 답글

진리의 둘 다......... 고성능 AI 서버 설치할 정도의 하드웨어와 전기요금 감당이 가능하면 ESXi나 Proxmox로 둘 다 올리지 않을까요 ㅎㅎ

오늘도부자님의 댓글