애플 연구진, 화면 상황을 '보고' 이해할 수 있는 AI 개발

페이지 정보

본문

* VentureBeat 기사 - Apple researchers develop AI that can ‘see’ and understand screen context

https://venturebeat.com/ai/apple-researchers-develop-ai-that-can-see-and-understand-screen-context/

(기사 일부 Claude 3 Opus 번역)

애플 연구진이 화면 상의 모호한 개체 참조, 대화 맥락, 배경 상황을 이해할 수 있는 새로운 인공지능 시스템을 개발했습니다. 금요일에 발표한 논문을 보면, ReALM(Reference Resolution As Language Modeling)이라 불리는 이 시스템은 음성 어시스턴트와 더욱 자연스러운 상호작용을 가능하게 합니다. ReALM은 대규모 언어 모델을 활용해 화면 상의 시각적 요소에 대한 참조 이해를 포함한 복잡한 참조 해결 과제를 본질적인 언어 모델링 문제로 전환합니다. 이것으로 ReALM은 기존 방법보다 상당한 성능 향상을 달성할 수 있었습니다.

* arXiv 링크 - ReALM: Reference Resolution As Language Modeling

https://arxiv.org/abs/2403.20329

애플 연구진은 "대화형 어시스턴트가 참조를 포함한 맥락을 이해할 수 있어야 한다"고 밝혔습니다. 이들은 "사용자가 화면에 보이는 내용에 대해 질문할 수 있도록 하는 것이 음성 어시스턴트에서 진정한 핸즈프리 경험을 제공하는 데 있어 필수"라고 설명했습니다.

ReALM의 주요 강점 중 하나는 화면 기반 참조를 처리하기 위해 파싱된 화면 상 개체와 그 위치를 사용하여 시각적 레이아웃을 포착하는 텍스트 표현을 생성함으로써 화면을 재구성하는 것입니다. 연구자들은 이 접근법을 참조 해결에 특화된 언어 모델의 파인 튜닝(미세 조정)과 결합했을 때 GPT-4보다 뛰어난 성능을 발휘할 수 있음을 입증했습니다.

"저희는 가장 작은 모델로 화면 상의 참조에 대해 5% 이상의 가시적인 성능 향상을 얻으면서, 다양한 유형의 참조에 걸쳐 유사한 기능을 가진 기존 시스템보다 큰 개선을 보여줬습니다"라고 연구진은 설명했습니다. "더 큰 모델은 GPT-4를 상당히 앞선다"고 강조했습니다. [후략]

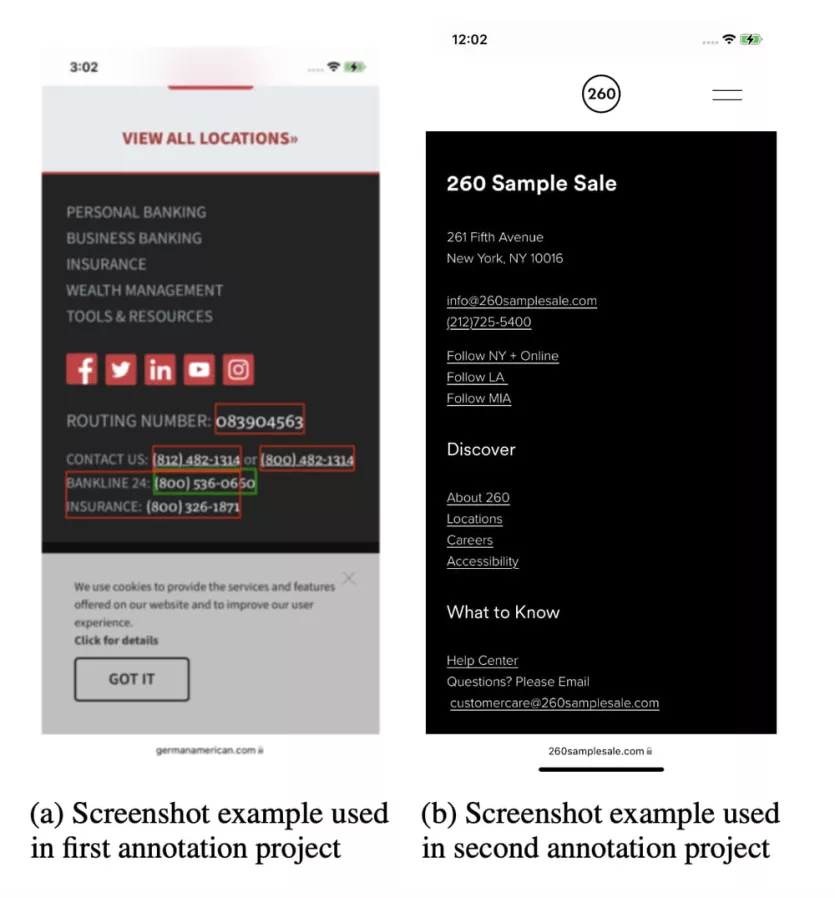

# 이미지 설명 - 애플 AI 시스템 ReALM은 이 예시 화면에 표시된 '260 Sample Sale'과 같은 화면 상 개체에 대한 참조를 이해할 수 있어, 음성 어시스턴트와 더 자연스러운 상호 작용을 가능하게 합니다. (이미지 출처: arxiv.org)

choochoo님의 댓글