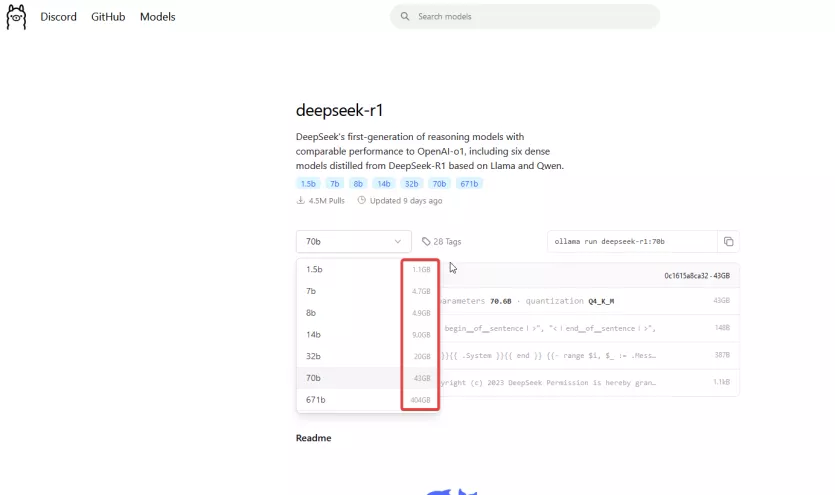

Ollama 에서 제공하는 로컬 LLM에서 이 크기는 뭘뜻하는건가요?

페이지 정보

작성자

날씨는어때

날씨는어때

날씨는어때

날씨는어때

작성일

2025.01.31 16:37

본문

0명

추천인 목록보기

댓글 6

/ 1 페이지

한글님의 댓글

작성자

한글

한글

한글

한글

작성일

02.03 12:24

모델 파일 사이즈이나, 메모리는 컨텍스트 크기에 따라서 달라집니다.

VRAM에 모델을 올리기에 부족하면 VRAM을 전혀 사용하지 않고 RAM에 다 올리고, 추론도 CPU로만 합니다. 8b 모델 까지는 돌려볼만 할겁니다.

VRAM에 모델을 올리기에 부족하면 VRAM을 전혀 사용하지 않고 RAM에 다 올리고, 추론도 CPU로만 합니다. 8b 모델 까지는 돌려볼만 할겁니다.

엔뜨님의 댓글

작성자

엔뜨

엔뜨

엔뜨

엔뜨

작성일

02.06 13:00

만약 VRAM 용량이 16gb 라고 해서 딱 거기에 맞게 다운하시면 안되고

30% 정도? 여유있게 맞추는게 안정적이라고 알고있어요.

30% 정도? 여유있게 맞추는게 안정적이라고 알고있어요.

kamziki님의 댓글

작성자

kamziki

kamziki

kamziki

kamziki

작성일

02.18 09:20

CLI(command)에서 ollama ps라고 치면 현재 ollama가 현재 video ram을 얼마나 이용하고 있는지 나옵니다. video ram보다 모델크기가 크면 일부는 ram으로 가져와서 모델을 돌리게 됩니다. 대신 속도는 조금 떨어지겠죠.

A350님의 댓글