안전을 경시하는 오픈AI(?), 떠나는 연구원

알림

|

페이지 정보

작성일

2024.05.20 10:10

본문

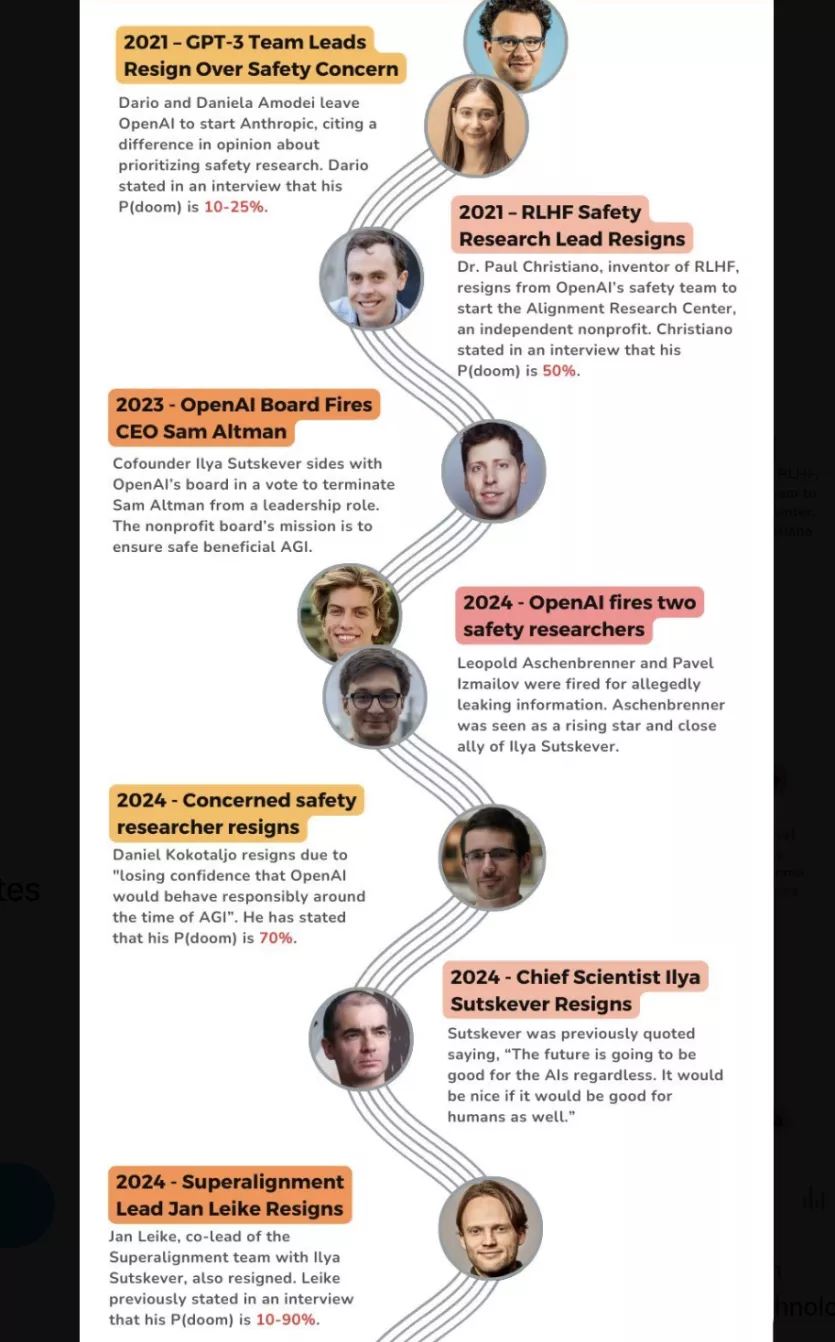

최근 오픈AI가 ‘GPT-4o’를 선보이며 또다시 놀랍고 빛나는 주목을 받았습니다. 하지만 한편에서는 공동 창업자 일리야 수츠케버가 사임하고, AI 안전을 책임지던 인물이 연이어 퇴사했습니다.

지난주 오픈AI의 초정렬(Super Alignment) 리더였던 얀 라이크가 소셜미디어 X(구 트위터)에 회사를 떠난다고 밝혔습니다. 그는 일리야 수츠케버와 함께 강력한 AI 시스템이 인간의 가치와 목표를 준수하도록 하는 초정렬팀을 이끌었던 책임자입니다.

그는 오픈AI가 차세대 AI 모델을 위해 안전, 사회적 영향, 기밀성 및 보안 등과 같은 문제에 더 많은 투자를 해야 한다고 했습니다. 인간보다 더 똑똑한 기계를 만드는 것은 본질적으로 위험한 작업이기에 오픈AI가 전 인류를 대신해 막중한 책임을 짊어져야 한다는 것입니다. 이 2명 외에도 올해에만 안전과 거버넌스 업무를 담당하던 주요 임원을 포함한 연구원 4명이 회사를 떠났습니다.

포스팅 전문 및 관련 뉴스 : https://naver.me/5pHJgJVS

댓글 2

/ 1 페이지

엘레지님의 댓글의 댓글

@RaPo님에게 답글

떠난 사람들은 스타트업 창업이든 다른 빅테크로의 이직이든, 계속 '안전한 AGI 개발'을 위한 노력을 하게 될 것입니다. 하지만 현재 이 세계에서 독보적인 오픈AI가 안전을 경시하고, 멋진 AI 개발에만 매몰된다면 큰 문제이지 않을까 싶네요. 오픈AI의 선의에만 기대할 수 없고, 견제할 수 있는 여러 제도와 장치들이 필요하지 않을까 싶습니다.

RaPo님의 댓글

사용자들이 OpenAI제품을 안쓰도록 더 좋은 제품을 만드려고 나가는 걸까요?