스마트폰에서 로컬 LLM 돌리기 (PocketPal 앱 활용)

페이지 정보

아름다운별

아름다운별

본문

아래에 다른 회원님께서 맥에서 로컬 설치하는 글을 올려주셔서 저도 올려봅니다.

https://damoang.net/lecture/8930

폰에서도 로컬 LLM을 돌릴 수 있는 앱이 있더라고요.

광고 없고, 오픈 소스인 앱 찾다가 발견했습니다.

주의 사항으로,

- 모델 돌리면 전화기가 뜨겁습니다.

- 아직 멀티모달 (이미지를 첨부하면 읽어준다던가....) 기능은 지원하지 않는 것 같습니다.

iOS와 안드로이드용이 있다고 하는데 저는 안드로이드에서 일단 설치해 봤네요.

a-ghorbani/pocketpal-ai: An app that brings language models directly to your phone.

https://github.com/a-ghorbani/pocketpal-ai

* 앱스토어 (iOS) - https://apps.apple.com/kr/app/pocketpal-ai/id6502579498

* 구글플레이 (안드로이드) - https://play.google.com/store/apps/details?id=com.pocketpalai&hl=ko

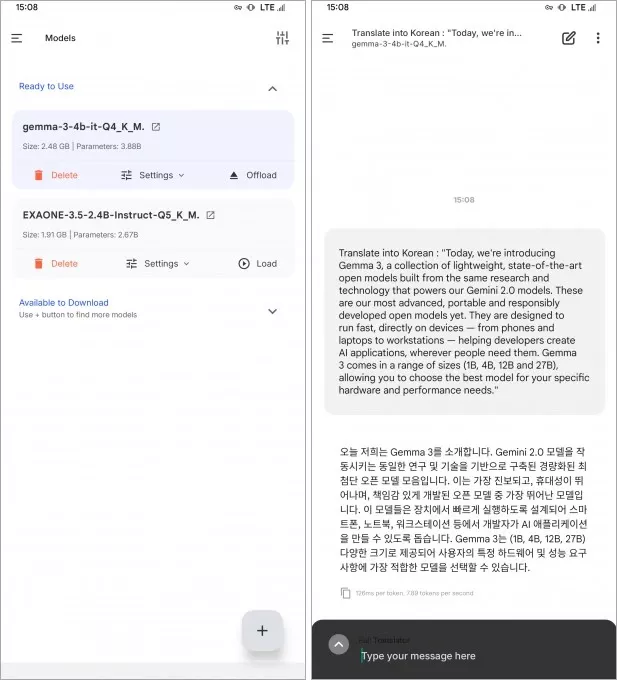

실행하고 처음에 보면 왼쪽 위를 보시면 三 메뉴 있는데 메뉴 안의 Models 를 선택하시고,

아래쪽 (+) 버튼 누르면 이런 언어모델이 많이 공유되는 허깅페이스에서 받아올 수 있는 기능이 있습니다.

파일 포맷이 'GGUF' 인 것을 요구하는데,

레딧 r/LocalLLAMA 게시판 보니까 "bartowski" 라는 유저가

이런 변환 작업을 많이 해 줘서 많이 쓰는 것 같더라고요.

예를 들어 최근 구글이 발표한 Gemma 3은 아래 링크에서

12B : https://huggingface.co/bartowski/google_gemma-3-12b-it-GGUF

4B : https://huggingface.co/bartowski/google_gemma-3-4b-it-GGUF

(12B도 RAM 용량이 넉넉하다면 실행은 가능하지만, 토큰 생성 속도가 느려 4B를 추천드립니다)

아니면 LG 엑사원 3.5도 2.4B가 있어서 폰에서 실행하기에는 충분합니다.

https://huggingface.co/bartowski/EXAONE-3.5-2.4B-Instruct-GGUF

모델이 설치되면 Models 페이지에서 볼 수 있고 대화도 시작할 수 있습니다.

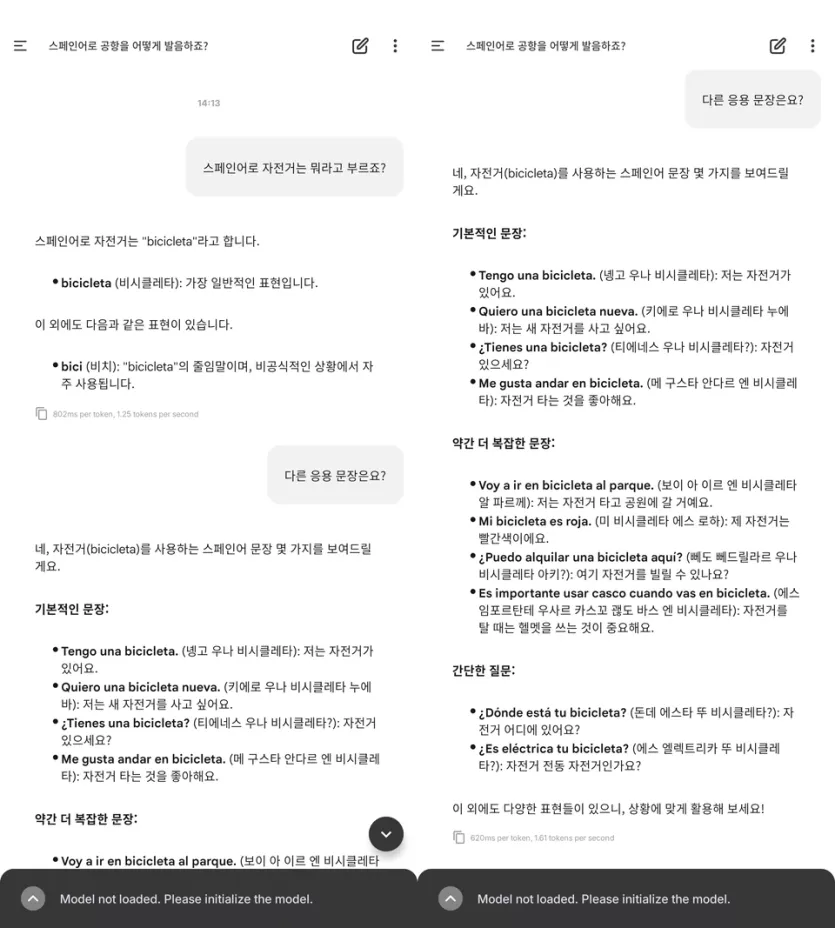

다만 어떤 정보에 대한 사실 확인 용도로는 적합하지 않은 것 같고요.

그냥 오프라인 번역기나 간단한 대화 정도로 가끔 활용 중입니다.

본문을 길게 쓰는 것보다 다른 회원님과 댓글로 대화하는 것이 나을 것 같아 여기까지 쓰겠습니다.

혹시 궁금한 점 있으시면 댓글 남겨주세요.

최면님의 댓글

감사합니다.