Deepseek 로컬설치 및 사용소감

페이지 정보

작성자

Dymaxion

Dymaxion

Dymaxion

Dymaxion

작성일

2025.01.29 20:21

본문

## Deepseek 로컬설치 및 사용소감

* Deepseek 때문에 난리가 났길래

* 저는 소프트웨어 개발자도 아닌데 로컬설치를 해 보았습니다.

* 이쪽 생태계는 엄청나게 발달이 잘 되어 있더군요.

* 설치는 뭐 명령어 몇 개 쳐 넣으니깐 그냥 끝나더라고요.

## 하드웨어

* 회사에서 수치해석용으로 사용하는 워크스테이션

* 라이젠 스레드리퍼 + 그래픽카드는 NVIDIA RTX A6000

* 윈도우11

## 설치순서

1. Ollama 설치 (Scoop 사용) : scoop install extra/ollama-full

2. Deepseek R1 32b 설치 : ollama run deepseek-r1:32b

- 더 큰 모델로 70b 등이 있었는데, 워크스테이션 자원을 다 쓰기는 좀 그래서 32b 선택

- 그래픽카드 vram이 49GB 정도 되는데, 돌려보니깐 절반 정도 점유하고 있는 것으로 보임

3. 파이썬 3.11 설치 (conda 사용) : conda create --name open-webui python=3.11

4. 파이썬 3.11 환경 진입 (conda 사용) : conda activate open-webui

5. Open-webui 설치 (conda 사용) : pip install open-webui

6. Open-webui 실행 : open-webui serve

## 실제 사용

1. 웹브라우저로 접속 : 로컬호스트:8080

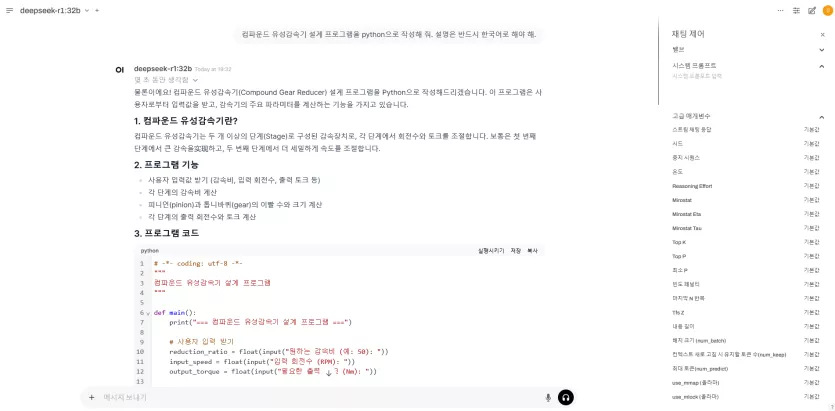

2. 질문 : 컴파운드 유성감속기 설계 프로그램을 python으로 작성해 줘. 설명은 반드시 한국어로 해야 해.

3. 답변 :

* 모든 내용 복사는 생략합니다. 답변이 상당히 풍부하네요.

* 완벽한 파이썬 코드가 만들어졌고, 주석도 제대로 달려 있고, 설명도 한국어로 되어서 나옵니다.

* 심지어 파이썬 코드에는 '실행하기' 버튼도 있어서, 실행하니깐 입력창까지 나와서 입력값을 넣으니깐

* 그대로 실행되어서 결과가 촤라락 나옵니다.

* 같은 질문을 기존의 ChatGPT, Gemini 등의 다른 서비스에서는 만족스러운 결과를 받아본 적이 없습니다. (무료버전)

* 나오는 파이썬 코드도 곧바로 실행이 안되는 버그가 많은 코드가 나오는 경우가 대부분이었고요.

* 가장 큰 모델이 아닌데도 불구하고, 실제 실무에서 사용 가능한 수준의 답변이 나오네요.

* 회사 안에 몇 몇 동료들한테 써보라고 권해봐야겠어요.

## 토의

* 제가 알기로는 Deepseek는 뭔가 대단한 신기술이 들어간게 아니고

* 기존에 공개된 다른 코드들을 기반으로 다이어트를 빡시게 한 걸로 알고 있는데

* 대신 학습이 굉장히 잘 되어 있는 모델인 것 같습니다.

* 학습이 잘 된 이유는 뭐 중국이니깐 가능했던거겠죠.

* 암튼 놀랍네요.

* 워크스테이션 급에서 이런 결과를 보다니... 헐

27명

추천인 목록보기

댓글 9

/ 1 페이지

셀빅아이님의 댓글

작성자

셀빅아이

셀빅아이

셀빅아이

셀빅아이

작성일

01.29 22:02

이정도면 VRAM 많은 3090ti 급에서도 무난히 돌릴 수 있지 않을까요?ㄷ

개인이 꾸밀 수 있는 정도에서 무제한으로 쓸 수 있다는게 엄청나네요.ㄷ

개인이 꾸밀 수 있는 정도에서 무제한으로 쓸 수 있다는게 엄청나네요.ㄷ

Dymaxion님의 댓글의 댓글

작성일

01.30 13:15

@Sain님에게 답글

웹서비스보다 작은 모델이라 더 니은건 없을거에요. 대신 사용자 폭증때 응답 늦을일 없다는 정도.... 개인정보 안 털리는거...

셀빅아이님의 댓글

작성자

셀빅아이

셀빅아이

셀빅아이

셀빅아이

작성일

01.30 18:36

Dymaxion님 사용기 보고 LM스튜디오로 1.5b 짜리 설치해서 써봤습니다.

작은 모델이라 그런지 한글로 질문은 시간도 더 오래걸리고, 답변도 잘 안나와서 영문으로 써봤는데, 간단한것 들은 시간 1분내외로 잘 답변해주는것 같습니다.

작은 모델이라 그런지 한글로 질문은 시간도 더 오래걸리고, 답변도 잘 안나와서 영문으로 써봤는데, 간단한것 들은 시간 1분내외로 잘 답변해주는것 같습니다.

Dymaxion님의 댓글의 댓글

작성일

01.30 18:45

@셀빅아이님에게 답글

작은 모델은 확실히 성능이 떨어지긴 하나 보군요.... 그래도 PC에서 돌리는게 가능한 언어모델이라는건 상상도 못했었는데 좀만 더 기다리면 진짜 PC급에서 쓸만한게 툭 튀어나올지도 모르겠네요

셀빅아이님의 댓글의 댓글

작성일

01.30 19:00

@Dymaxion님에게 답글

제 PC사양이 i3-12100 (16G) / RX580 (8G)라 민망한 수준에도 돌아가는게 신기합니다.;

칼쓰뎅님의 댓글

작성자

칼쓰뎅

칼쓰뎅

칼쓰뎅

칼쓰뎅

작성일

01.31 01:24

돌려보신건 r1으로 증류된 qwen2.5 모델입니다. (r1하고는 다릅니다...)

개발자입장으로는...

qwen 2.5 coder보다 좀 못한것 같았습니다 ㅡㅡ;;;

아무래도 사전지식이 코드 전용으로 만들어진 coder모델에 비해서 빈약한 느낌이네요.

논리적으로는 우수하겠지만, 아는게 적으니... 제대로 못푼달까요.

그래서인지, distill버젼하고 coder버젼을 merge하려는 시도도 있더군요 ㄷㄷㄷ

물론 현재는 좀 제대로 동작하진않습니다.

deepseek쪽에서 qwen2.5coder 를 증류 한번 해줬음 좋겠는데 말입니다 ㅋ

개발자입장으로는...

qwen 2.5 coder보다 좀 못한것 같았습니다 ㅡㅡ;;;

아무래도 사전지식이 코드 전용으로 만들어진 coder모델에 비해서 빈약한 느낌이네요.

논리적으로는 우수하겠지만, 아는게 적으니... 제대로 못푼달까요.

그래서인지, distill버젼하고 coder버젼을 merge하려는 시도도 있더군요 ㄷㄷㄷ

물론 현재는 좀 제대로 동작하진않습니다.

deepseek쪽에서 qwen2.5coder 를 증류 한번 해줬음 좋겠는데 말입니다 ㅋ

Commander님의 댓글

ChatGPT 이제 구독.. 해제해야할까 고민하고 있어요 ㅋㅋ